AI L’IA ne se contente pas de transformer votre entreprise ; elle redéfinit les règles en matière de risque, de confiance et de gouvernance. Le récent sommet numérique BigID a réuni des experts du secteur pour explorer les risques liés à l’IA, les mesures de sécurité et les stratégies d’innovation responsable, attirant plus de 1 100 participants désireux d’approfondir leurs connaissances sur la gouvernance de l’IA et la réduction des risques.

La séance principale mettant en vedette Allie Mellen, analyste principale chez Forrester Research Spécialisée dans la sécurité et la gestion des risques, elle a offert une perspective éclairante sur les défis et les stratégies entourant Sécurité de l'IA et de l'IA généralePour les professionnels de la cybersécurité, et notamment les RSSI, cette conférence a présenté des pistes concrètes pour aider les organisations à se protéger. modèles d'IA sécurisés et les infrastructures, tout en se préparant aux risques posés par une augmentation croissante des agentique systèmes.

L’évolution du paysage des risques liés à la sécurité de l’IA

Allie Mellen a débuté son intervention en soulignant le caractère dynamique et en constante évolution du domaine de la sécurité de l'IA. Elle a notamment évoqué les progrès réalisés dans les applications d'IA générative (GenAI), les vulnérabilités matérielles et l'impact de modèles tels que… Gémeaux et ChatGPTL’urgence de préserver les modèles et les infrastructures ne saurait être surestimée.

Mellen a souligné que les attaques contre l'IA restent pour l'instant du domaine académique, souvent issues de chercheurs explorant des vulnérabilités ou des techniques de piratage éthiques (« white hat »). Cependant, la situation évolue :

Cela va changer. Nous allons assister à une recrudescence de ces attaques… bien plus ciblées non seulement sur les modèles eux-mêmes, mais aussi sur les données sous-jacentes et l’infrastructure qui les entoure.

Principales vulnérabilités et menaces

L'un des passages les plus marquants du discours d'ouverture était l'analyse de Mellen sur Les 10 principales menaces selon l'OWASP pour les grands modèles de langage (LLM) et l'IA générale Ces menaces mettent en lumière les failles potentielles des systèmes d'IA générale à tous les niveaux, soulignant les vulnérabilités que les RSSI doivent impérativement corriger.

Menaces OWASP GenAI :

- Attaques par injection rapide : Pouvoir accéder à une invite de commandes et y injecter un élément qui permet d'obtenir un résultat que l'on ne pourrait pas obtenir autrement.

- Divulgation d'informations sensibles : Les systèmes d'IA, en particulier ceux intégrés à des API ou à des ensembles de données externes, peuvent exposer par inadvertance des données privées ou confidentielles.

- Empoisonnement du modèle/des données : En falsifiant les données d'entraînement ou opérationnelles, les attaquants peuvent corrompre la base de connaissances sous-jacente d'un système, ce qui peut entraîner une désinformation ou une prise de décision erronée.

- Agents d'IA surprivilégiés : Un thème récurrent en matière de sécurité de l'IA est l'importance de maintenir un contrôle strict sur les autorisations des agents :

Nous devons garantir un ensemble minimal d'autorisations, de capacités minimales, d'outils et de pouvoir de décision pour les agents d'IA.

Risques liés aux systèmes d'agents d'IA

Les agents d'IA – la tendance croissante vers des systèmes capables d'agir et de prendre des décisions de manière autonome – présentent des risques importants. Mellen a classé ces risques en catégories concrètes que les organisations devraient évaluer avec soin :

- Détournement d'objectifs et d'intentions : Les attaquants peuvent manipuler les agents d'IA pour détourner leur objectif initial.

- Corruption cognitive et de la mémoire : L’empoisonnement des données ou de la mémoire des modèles d’IA peut entraîner des défaillances importantes, de la désinformation et des erreurs opérationnelles.

- Agence sans entraves : Des autorisations excessives accordées aux agents d'IA pourraient accroître la surface d'attaque, rendant les systèmes vulnérables à des actions ou décisions non autorisées.

- Fuite de données : La prévention des pertes de données (DLP) est essentielle pour protéger les informations sensibles partagées ou générées par les agents d'IA, notamment lorsqu'ils communiquent avec l'extérieur.

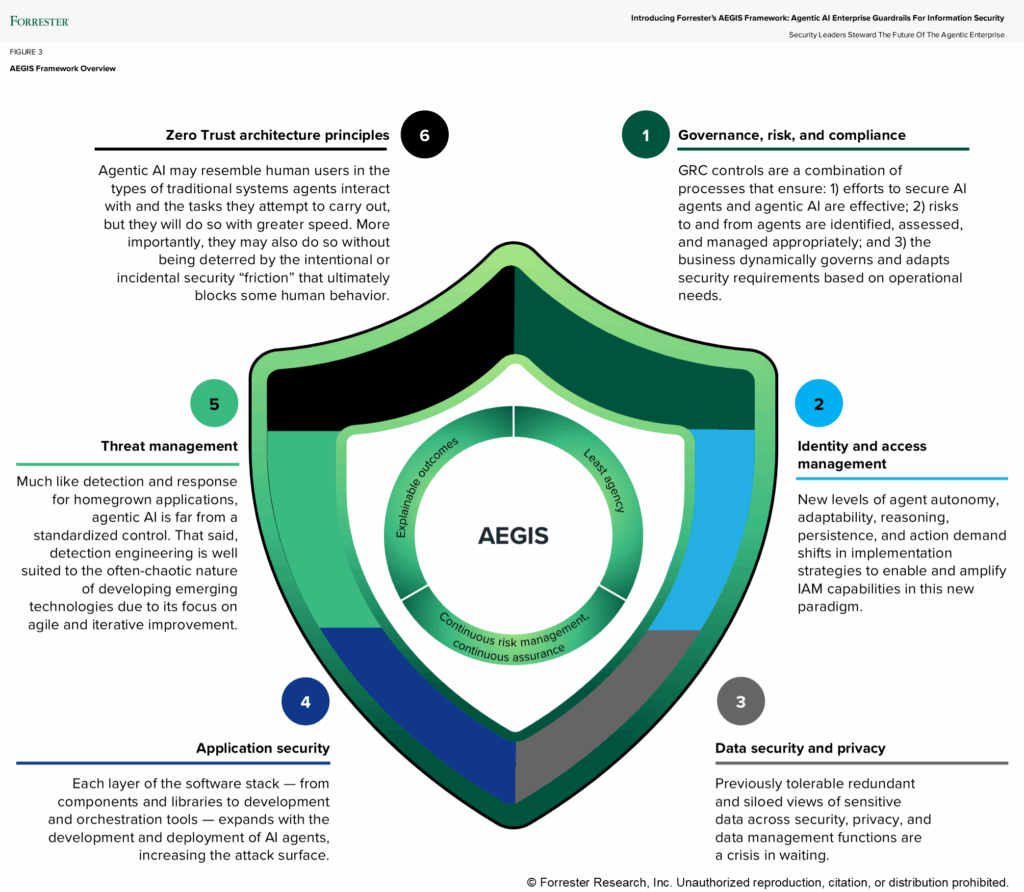

Cadres et meilleures pratiques : Le cadre Aegis

Mellen a ensuite présenté le Cadre Aegis – Garde-fous d'IA agentique pour la sécurité de l'information – comme approche proactive de la gestion des risques liés à l’IA. Ce cadre propose trois principes fondamentaux que les RSSI devraient intégrer à leur feuille de route en matière de sécurité de l’IA :

- Agence minimale : Veillez à ce que les agents d'IA ne disposent que des autorisations et des accès strictement nécessaires à l'exécution de tâches spécifiques.

- Gestion continue des risques : Mettre en place un cadre de gestion des risques robuste pour surveiller, évaluer et atténuer les risques en temps réel.

- Garde-fous et gouvernance : Mettre en œuvre des politiques et des procédures strictes pour contrôler les actions que les agents d'IA peuvent entreprendre, ainsi que leurs communications au sein des systèmes internes et externes :

Surveillance régulière du modèle, validation des entrées/sorties et garde-fous… tous ces éléments doivent être intégrés à votre processus pour garantir la sécurité.

Renforcement des connaissances organisationnelles et de la gouvernance

Au-delà des aspects techniques, Mellen a souligné l'importance de la formation et de la transformation culturelle au sein des organisations. Les responsables de la sécurité doivent passer d'une image de frein à celle de conseillers de confiance, moteurs d'innovation.

Adoptez l'IA et faites clairement savoir à l'organisation que vous adoptez, comprenez et valorisez son utilisation.

Sensibiliser les acteurs non spécialisés en sécurité, comme les data scientists, est essentiel pour promouvoir les bonnes pratiques de sécurité. Mellen a encouragé les RSSI et les équipes de sécurité à créer un environnement ouvert où les questions sur l'IA sont les bienvenues.

De plus, donner aux équipes de science des données les moyens de devenir des référents en sécurité peut contribuer à combler le fossé entre l'innovation technique et sa mise en œuvre sécurisée.

Synthèse : Zero Trust et IA défensive

À mesure que les capacités de l'IA se développent, mise en œuvre des principes de confiance zéro est essentiel :

L'idée de moindre privilège cela va vous être d'une aide précieuse.

L'utilisation défensive de l'IA était un autre pilier de la session de Mellen. Les organisations doivent tirer parti des atouts de l'IA pour détecter et contrer les menaces qui s'appuient sur elle. De la compréhension des campagnes d'hameçonnage utilisant l'IA à la gestion des menaces internes grâce à une gestion robuste des identités et des accès, les défenses proactives sont essentielles.

Nous devons utiliser l'IA pour nous défendre contre les attaques menées grâce à l'IA. Il n'y a pas d'autre solution.

C’est là qu’intervient BigID

Pour les RSSI et les équipes de sécurité, la protection de l'IA commence par la protection des données. Chaque modèle d'IA, qu'il soit développé en interne ou acquis, repose sur des données qui doivent être découvertes, classifiées, gouvernées et sécurisées avec précision. C'est là que BigID intervient.

BigID offre aux responsables de la sécurité la visibilité, le contrôle et les informations nécessaires pour protéger les données qui alimentent l'IA. La plateforme détecte et classe automatiquement toutes les données sensibles, réglementées et propriétaires, qu'elles soient stockées dans le cloud, sur site ou dans les pipelines d'IA. Les équipes peuvent ainsi identifier les données utilisées, leur flux et les personnes autorisées à y accéder.

Grâce aux fonctionnalités de sécurité des données basées sur l'IA de BigID, les organisations peuvent :

- Localisez et protégez les données sensibles et l'IA. dans les ensembles d'entraînement des modèles et les interactions entre agents, avant même l'apparition des risques d'exposition.

- Détecter et prévenir les fuites de données avec des politiques de classification et de contexte avancées qui s'alignent sur confiance zéro principes ; protection rapide ; et garde-fous contre les risques liés à l'IA

- Gouverner l'accès aux données avec des contrôles précis pour garantir le principe du moindre privilège aux agents d'IA et imposer la minimisation des données auxquelles l'IA peut accéder.

- Surveiller et auditer les pipelines de données d'IA repérer les anomalies, les erreurs de configuration ou les données fantômes qui augmentent les risques.

- Opérationnaliser la gouvernance de l'IA en harmonisant les politiques de sécurité, de confidentialité et de conformité entre les équipes et les technologies.

BigID helps enterprises build the foundation for secure, responsible AI – strengthening trust, minimizing risk, and accelerating innovation with confidence.

En résumé : avant de pouvoir sécuriser l’IA, il faut sécuriser ses données. BigID rend cela possible.

Lors de son discours d'ouverture, Allie Mellen a incité les responsables de la sécurité à repenser leur approche de la sécurité de l'IA. En s'appuyant sur des cadres de référence comme Aegis et en mettant en œuvre des solutions de leaders du secteur tels que BigID, les organisations peuvent protéger leurs innovations basées sur l'IA tout en gérant les risques liés aux systèmes multi-agents et aux applications d'IA générale. Dans un monde où la prise de décision est de plus en plus pilotée par l'IA, ces mesures ne sont pas de simples options : elles sont indispensables.

Vous avez manqué la discussion en direct ? Restez informé(e) ! événements futurs ou programmer une démonstration individuelle pour pérenniser votre programme de sécurité IA.