Agents d'intelligence artificielle Les outils expérimentaux ne sont plus cantonnés aux laboratoires d'innovation. Ils sont déjà intégrés aux environnements d'entreprise : lecture de fichiers, réponse aux tickets, le provisionnement de l'accès, en générant des rapports et en lançant remédiation Ces actions concernent l'ensemble des systèmes critiques. Leur adoption s'accélère car elles réduisent les frictions et automatisent la prise de décision à grande échelle.

Pourtant, de nombreuses organisations déploient ces agents en partant d'une hypothèse risquée : celle que les contrôles IAM existants, la sécurité des modèles ou les cadres de gouvernance de l'IA de haut niveau suffisent. Si ces contrôles demeurent nécessaires, ils sont fondamentalement incomplets pour les systèmes autonomes capables de raisonner, d'agir et d'accéder et de déplacer en continu des données sensibles sans intervention humaine.

Les agents d'IA ne sont pas de simples modèles. Ce sont des acteurs opérationnels. Et ces acteurs, fonctionnant à la vitesse de la machine et disposant d'un accès permanent aux données de l'entreprise, exigent une nouvelle discipline de sécurité, fondée sur les données et non uniquement sur l'identité ou l'infrastructure. C'est le fondement de Gestion de la posture des agents IA.

Agents autonomes en tant qu'initiés invisibles

Les équipes de sécurité maîtrisent parfaitement la gestion des risques humains. Elles suivent les utilisateurs, leurs rôles, leurs droits d'accès et leurs activités afin de comprendre qui a accès à quoi et pourquoi. Ce modèle s'avère inadapté lorsqu'il est appliqué aux agents d'IA.

Les agents ne s'authentifient pas de manière interactive, ne demandent pas d'accès de façon répétée et n'éprouvent aucune difficulté à agir. Une fois déployés, nombre d'entre eux fonctionnent en continu à l'aide de comptes de service, d'applications OAuth ou de clés API, souvent en dehors des procédures de vérification d'identité classiques. Au fil du temps, ils agissent comme des utilisateurs internes bénéficiant de privilèges permanents.

Ce défi est souvent présenté comme un Gouvernance de l'IA problème, mais à la base, c'est un problème de sécurité des données. Le principal risque ne réside pas dans l'agent lui-même, mais dans les données sensibles, réglementées et essentielles à l'activité de l'entreprise auxquelles il peut accéder et sur lesquelles il peut agir.

Définition de la gestion de la posture des agents d'IA

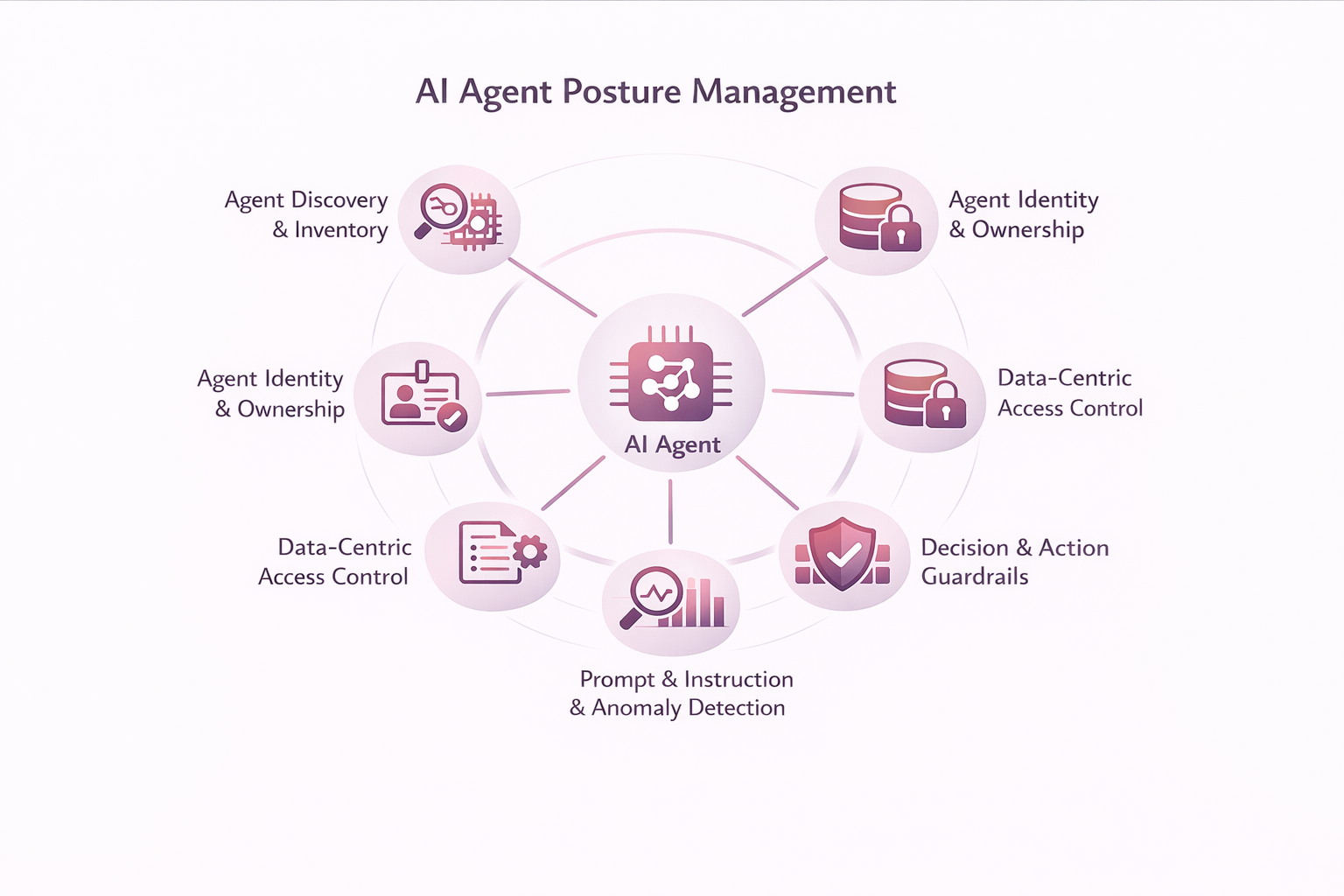

La gestion de la posture des agents d'IA assure la visibilité, le contrôle et la gouvernance continus des données d'entreprise auxquelles ces agents peuvent accéder, décider et agir. Elle étend la gestion de la posture de sécurité aux acteurs autonomes dont le comportement ne peut être entièrement anticipé lors du déploiement.

En pratique, elle permet aux responsables de la sécurité de répondre à des questions auxquelles les approches centrées sur l'identité ou sur les modèles ne peuvent pas répondre de manière fiable :

À quelles données cet agent peut-il accéder, et quelles données utilise-t-il réellement ? Quelles actions peut-elle entreprendre avec ces données ? Son comportement reste-t-il conforme à la politique et aux objectifs ? Et en cas de problème, ses actions peuvent-elles être expliquées, limitées ou stoppées ?

Sans visibilité et contrôle au niveau des données, ces questions restent sans réponse, quelle que soit la qualité de la gestion des identités ou de la gouvernance des modèles.

Capacités fondamentales de la gestion de la posture des agents IA

Découverte et inventaire des agents

La gestion de la posture des agents d'IA commence par la visibilité. Les organisations ne peuvent gouverner ce qu'elles ne voient pas, et la plupart des entreprises ne disposent pas d'un inventaire complet des agents d'IA déjà actifs dans leurs environnements.

Les agents sont créés par les développeurs, intégrés aux plateformes SaaS, déployés via des outils d'automatisation ou activés par des fonctionnalités d'IA au sein d'applications existantes. Nombre d'entre eux s'authentifient de manière non interactive et fonctionnent en continu, ce qui les place en dehors des inventaires d'identité traditionnels.

Découverte d'agents établit les bases de la gestion des postures en identifiant et en recensant en permanence les agents au sein de l'entreprise, notamment :

- Découverte d'agents d'IA à travers les applications, les services cloud et les frameworks d'automatisation

- Identification des identités non humaines telles que les principaux de service, les applications OAuth et les accès basés sur les API

- Corrélation des agents avec les données auxquelles ils accèdent et qu'ils modifient réellement

- Détection des éléments non gérés, dormants ou agents surprivilégiés

Sans détection, les agents agissent comme des infiltrés invisibles. Avec la détection, les contrôles de posture peuvent être appliqués de manière intentionnelle et cohérente.

Identité et propriété de l'agent

Une fois découverts, les agents doivent être identifiés et leur responsabilité établie. Chaque agent d'IA doit être considéré comme un acteur de sécurité de premier plan, doté d'un objectif et d'un périmètre d'action définis.

L’identité et la propriété des agents garantissent la responsabilisation en :

- Attribuer une identité unique et vérifiable à chaque agent

- Définir clairement le propriétaire et documenter l'objet de l'entreprise

- Définir des limites de portée explicites entre les systèmes et les domaines de données

L'identité seule, cependant, ne suffit pas. Savoir OMS un agent n'explique pas quelles données utilise-t-il ? ou comment il évolue au fil du temps— c’est pourquoi l’identité doit être associée au contexte des données.

Classification des agents et profilage des risques

La découverte et l'identification ne suffisent pas à elles seules à établir une position. Tous les agents ne présentent pas le même niveau de risque, et les autorisations, à elles seules, ne donnent qu'une image incomplète.

Classification des agents et Profilage des risques évalue les agents en fonction de leur comportement observé, notamment :

- La sensibilité et la nature réglementaire des données consultées

- Quelles données les agents lisent, écrivent ou propagent réellement

- L'étendue de l'accès à travers les systèmes et les régions

- Le niveau d'autonomie et le pouvoir d'action de l'agent

Les profils de risque doivent être constamment mis à jour en fonction de l'évolution des agents. En fondant la classification sur des données réelles d'interaction, les organisations peuvent concentrer leurs contrôles là où ils sont le plus pertinents.

Contrôle d'accès centré sur les données

Les autorisations au niveau du système sont trop grossières pour les agents autonomes qui interagissent directement avec des informations sensibles.

Le contrôle d'accès centré sur les données applique le principe du moindre privilège au niveau des données en activant :

- Visibilité sur l'accès spécifique des agents de données

- Décisions d'accès tenant compte de la sensibilité, fondées sur la classification et le risque

- Accès limité à une tâche et à une durée déterminée plutôt qu'à des privilèges permanents

Sans contrôles au niveau des données, les organisations ne peuvent pas empêcher la surexposition, même si les identités et les autorisations semblent correctes sur le papier.

Garde-fous pour la décision et l'action

Les agents d'IA ne se contentent pas d'analyser ; ils agissent. Plus leur autonomie augmente, plus leur impact potentiel s'accroît.

Les garde-fous de décision et d'action définissent les limites opérationnelles, notamment :

- Limites explicites sur les actions autorisées

- Approbation humaine pour les décisions à haut risque

- Mesures de protection contre les actions irréversibles, telles que la suppression ou le partage

- Interrupteurs d'arrêt d'urgence et voies de restauration

L'automatisation sans garde-fous amplifie les risques plutôt que l'efficacité.

Gouvernance des consignes et des instructions

Les invites et instructions des agents constituent une surface d'analyse de stratégie essentielle qui influence directement les comportements.

La gouvernance par promptitude et instruction permet aux organisations de :

- Instructions relatives à la version et à l'agent d'audit

- Détecter la dérive ou la manipulation de l'invite

- Distinguer l'intention du système du contexte fourni par l'utilisateur

- Appliquer les politiques de données et de conformité dans le cadre du raisonnement des agents

Sans visibilité sur les instructions, le comportement des agents devient imprévisible et ingouvernable.

Surveillance continue et détection des anomalies

Les commandes statiques sont inefficaces dans les environnements dynamiques. La gestion de la posture des agents IA exige une visibilité continue sur leur comportement.

La surveillance continue et la détection des anomalies permettent :

- Surveillance continue des accès aux données et des actions

- Évaluation comportementale de référence par agent

- Détection des comportements anormaux ou contraires aux politiques

- Corrélation avec l'identité, les risques liés aux données et les signaux de menace

Cela permet une intervention précoce, avant que des écarts mineurs ne deviennent des incidents.

Les risques que cette discipline vise à prévenir

Sans ces capacités, les organisations s'exposent à des risques croissants : dérive des privilèges, exfiltration silencieuse de données via des processus légitimes, injection de code malveillant et perte de responsabilité lors des enquêtes. En cas d'incident, imputer les résultats à “ l'IA ” est insuffisant et indéfendable.

Pourquoi la gestion de la posture des agents IA repose fondamentalement sur les données

Une grande partie du marché se concentre sur la sécurisation des modèles ou la gestion des identités. Ces approches sont nécessaires, mais elles ne permettent pas de s'attaquer au principal risque : la manière dont les agents autonomes interagissent avec les données de l'entreprise au fil du temps.

- Les contrôles d'identité uniquement ne permettent pas de voir la sensibilité des données ni leur utilisation réelle.

- Les commandes basées uniquement sur le modèle ne peuvent pas régir les actions en aval.

Sans contexte de données, la posture est déduite et non imposée. La gestion de la posture des agents IA doit s'appuyer sur un plateforme de sécurité axée sur les données qui comprend la sensibilité des données, leur exposition et leur activité en temps réel.

Comment BigID permet une gouvernance axée sur les données pour les agents d'IA

BigID Aide les organisations à découvrir et à classer les données sensibles, à comprendre les accès et l'exposition, à surveiller l'activité des données et à appliquer des mesures correctives conformes aux politiques en vigueur à grande échelle. La gestion de la posture des agents IA étend ces capacités aux acteurs autonomes opérant sur l'ensemble du parc de données.

Plutôt que de se demander si un modèle d'IA est “ sûr ”, les organisations devraient se poser une question plus pragmatique : nos données restent-elles gouvernées lorsque l'IA est autorisée à agir ? C'est ce changement de perspective qui permet l'adoption de l'IA sans perte de contrôle.

De la gouvernance de l'IA à la posture des agents

Les agents d'IA sont déjà déployés à grande échelle au sein des entreprises. Les organisations qui les considèrent comme de simples outils auront du mal à en garder le contrôle. Celles qui les appréhendent comme des entités à part entière, régies par des contrôles axés sur les données, pourront déployer l'IA à grande échelle de manière sûre et responsable.

La gestion de la posture des agents IA n'est pas une perspective d'avenir. Elle représente la prochaine évolution de la sécurité des données, et la définir dès maintenant garantit qu'elle évoluera selon vos besoins, et non en réaction à un incident.

Vous voulez en savoir plus ? Planifier un rendez-vous 1:1 avec l'un de nos experts en IA et en sécurité des données.