En 2025, les entreprises ont franchi un cap décisif. L'IA a cessé d'être un assistant passif pour devenir un acteur à part entière des processus métier : génération de code, émission d'alertes, planification d'actions et même intégration autonome d'outils. Cette nouvelle génération de systèmes d'IA est appelée IA agentique—crée des opportunités et des risques à une échelle sans précédent. Presque tous les secteurs d'activité sont confrontés à des questions comme Comment faire confiance aux systèmes autonomes ? et Comment combler les angles morts en matière de sécurité que les outils traditionnels ne peuvent pas détecter ? La réponse pour les équipes tournées vers l'avenir est Remédiation par agents— une nouvelle catégorie de contrôles qui boucle la boucle entre la détection et l'action dans les programmes de sécurité des données. Ce guide vous offre une compréhension complète de ce qu'est la remédiation automatisée, de son importance et de son lien avec… Gestion de la sécurité des données (DSPM), et comment la mettre en œuvre sans perdre de vue les risques.

Qu’est-ce que la remédiation par agent ? Une définition claire

La remédiation proactive consiste à exploiter l'IA proactive pour identifier, prioriser et exécuter des actions de réduction des risques sur l'ensemble de vos données, avec une intervention manuelle minimale. Elle va au-delà des flux de travail réactifs actuels, où les équipes constatent les risques mais peinent à les corriger de manière systématique et à grande échelle.

Considérez la remédiation par l'agent comme :

- Une IA qui non seulement signale les expositions de données à risque, mais suggère — et peut mettre en œuvre — des actions sécurisées.

- Un système qui apprend en permanence du contexte afin de prioriser les correctifs les plus efficaces.

Il ne s'agit pas simplement d'automatisation scriptée. Il s'agit de adaptatif, contextuelet guidé par une intelligence des données approfondie.

Pourquoi la remédiation par agents chimiques est essentielle en 2026

L’IA agentique est désormais omniprésente, des générateurs de code aux flux de travail de sécurité du cloud. Mais cette même autonomie engendre de nouveaux risques que les outils de détection traditionnels ne peuvent gérer :

1. Surface d'attaque croissante due aux agents autonomes

Les systèmes d'IA agentiques exécutent des plans complexes, utilisent des outils et prennent des décisions sans intervention humaine. Cette capacité accroît le nombre de points de défaillance potentiels et de vecteurs d'exploitation. Des chercheurs démontrent que la prise de décision indépendante, la mémoire persistante et l'intégration d'outils dans les systèmes agentiques engendrent des risques de sécurité bien plus importants que les vulnérabilités classiques de l'IA.

2. Les menaces autonomes se multiplient

Les cybercriminels utilisent déjà l'IA agentive pour automatiser les attaques à grande échelle — du phishing à l'exploitation continue — comme l'ont montré les récents avertissements du secteur concernant “crime de l'ambiance” et les opérations adverses automatisées de l’IA. ».

3. Les outils traditionnels échouent face aux angles morts de l'agentivité

Les outils de sécurité traditionnels, tels que les solutions DLP classiques et l'automatisation basée sur des règles, ne disposent pas du contexte nécessaire pour comprendre l'importance d'une action ni pour réagir intelligemment lorsque des agents d'IA manipulent des données sensibles. DSPM a offert la première couche de visibilité et de classification ; la remédiation par agents apporte cette capacité. une réponse concrète associée à un raisonnement basé sur l'IA.

DSPM et remédiation par agents : une relation stratégique

Pour comprendre la remédiation par agent, vous devez d'abord comprendre la gestion de la posture de sécurité des données (DSPM).

Que fait le DSPM ?

DSPM découvre, inventorie et classe les données sensibles dans des environnements multicloud, SaaS et hybrides, permettant aux équipes de voir où se situe le risque et qui y a accès.

Le DSPM répond aux questions essentielles :

- Quelles sont les données sensibles concernées ?

- Où est-il stocké ?

- Qui peut y accéder ?

- Quel impact cela a-t-il sur la conformité ?

Pourtant, DSPM seul présente encore un écart d'exécution. C'est là que… remédiation par agent arrive.

Comment la remédiation par agents chimiques achève le cycle de vie

La remédiation par agents s'appuie sur DSPM en ajoutant :

- Priorisation des risques pilotée par l'IA basé sur le contexte réel.

- Suggestions de remédiation guidées adapté à votre environnement.

- Exécution semi-autonome ou entièrement automatisée des correctifs.

BigID combine de manière unique DSPM et remédiation par agent. Ainsi, vous ne vous contentez pas de constater le risque, vous le réduisez grâce à des résultats mesurables.

Cas d'utilisation concrets : de la théorie à l'impact

Voici des situations concrètes où la remédiation par agent excelle :

1. Réponse automatique à la divulgation de données sensibles

Votre équipe découvre que des données sensibles sont largement partagées dans des applications SaaS. Au lieu de procédures manuelles de gestion des incidents et de vérification, la remédiation automatisée suggère des configurations sécurisées et peut les appliquer automatiquement, réduisant ainsi le temps de résolution de plusieurs jours à quelques heures.

2. Correction des problèmes de configuration du cloud

Une politique de gestion des identités et des accès (IAM) à haut risque applique des droits trop permissifs. La remédiation proactive analyse le contexte, hiérarchise les risques et propose des actions correctives précises conformes à vos politiques de gouvernance.

3. Gouvernance de l'IA et prévention des pertes de données pour les copilotes

DSPM pour l'IA Ce système identifie les données à risque envoyées à des outils de génération externes. La remédiation automatique met en corrélation les tendances d'utilisation et corrige les risques de partage excessif avant qu'ils ne constituent des infractions à la conformité.

Risques liés à la mise en œuvre opérationnelle de l'IA agentielle — et comment éviter les angles morts

La remédiation par les agents confère un pouvoir, et ce pouvoir implique des responsabilités. Voici les principaux risques et comment les gérer :

1. Actions malavisées ou iniques

Les agents autonomes peuvent entreprendre des actions contraires aux politiques en vigueur. Il est donc impératif de mettre en place des mécanismes de gouvernance et des procédures d'escalade afin que les actions à fort impact nécessitent une approbation humaine.

2. Suggestions de remédiation incorrectes

L'IA peut avoir des hallucinations ou mal interpréter le contexte. Assurez-vous que votre système associe les suggestions de l'IA à des données réelles et à un contexte de classification approfondi.

3. Chaînes de données invisibles

La remédiation automatique ne peut corriger ce qu'elle ne détecte pas. Investissez dans une découverte continue des problèmes de sécurité des données (DSPM) dans tous les environnements et types de données.

4. Exigences en matière de gouvernance et d'audit

Documentez chaque action des agents dans des journaux et des pistes d'audit. Ce niveau de visibilité permet d'être prêt pour les audits et d'assurer une validation continue de la conformité.

Soutien de la recherche et signaux de l'industrie

Les cadres sectoriels et les recherches en matière de sécurité confirment ces tendances :

- OWASP libéré Les 10 principales menaces et guides d'atténuation spécifiquement destinés à la sécurité de l'IA agentique, mettant en évidence les menaces uniques que représentent les systèmes autonomes.

- McKinsey et d'autres experts en gestion des risques soulignent l'importance des cadres de sécurité multicouches pour Déploiement sécurisé d'une IA agentive.

- Les cabinets d'analystes suivent la convergence de DSPM, DLPet sécurité de l'IA en plateformes unifiées et axées sur l'intelligence.

Feuille de route opérationnelle pour 2026 et au-delà

Pour réussir la mise à l'échelle de la remédiation par agents :

Étape 1 : Visibilité DSPM de référence

Assurez-vous de disposer d'un inventaire complet des données, de leur classification et du contexte d'accès à l'ensemble de votre parc informatique.

Étape 2 : Intégration de la priorisation guidée par l'IA

Activez la priorisation par agent pour savoir quels risques sont les plus importants.

Étape 3 : Définir les chemins d’exécution sûrs

Élaborer des politiques qui définissent les cas où l'IA peut intervenir de manière autonome et ceux où une approbation humaine est requise.

Étape 4 : Retour d'information et validation continus

Examiner régulièrement les mesures correctives et leurs résultats afin d'affiner la logique de décision de l'agent.

Étape 5 : S’aligner sur les besoins des auditeurs et de la conformité

Conserver les preuves de contrôle et l'historique des mesures correctives pour répondre aux exigences réglementaires.

Plan d'action BigID : Opérationnaliser la remédiation agentique en toute confiance

1. Établir une visibilité approfondie des données

Déployer BigID DSPM à travers les environnements hybrides, multiclouds et SaaS découvrir et classer données sensibles, réglementées et exclusives.

Inventorier en permanence les ressources de données pertinentes pour l'IA, telles que les ensembles de données d'entraînement, les entrées d'invite, les sorties et les données fantômes utilisées par les agents d'IA.

2. Cartographiez les risques liés à l'IA dans vos données

- Utilisez l'IA de BigID cartographie des données capacités de détection :

- Artefacts de données générés par l'IA

- Utilisation de LLM par des tiers

- Les données alimentent les outils d'IA générative

3. Prioriser les risques grâce au renseignement contextuel

- L'effet de levier Score de risque contextuel de BigID classer les menaces selon :

- Impact sur l'entreprise

- Exposition réglementaire

- implication du système d'IA

4. Activer les flux de travail de remédiation agentique

- Configure automatisé ou des politiques de remédiation guidées pour:

- Données surexposées dans les outils de collaboration

- Droits toxiques dans les environnements cloud et SaaS

- Accès inapproprié aux ensembles d'entraînement de l'IA

5. Établir des garde-fous de gouvernance

- Utilisez le moteur de politiques de BigID pour appliquer :

- Limites de remédiation basées sur les rôles

- Flux de travail de remédiation alignés sur la conformité (par exemple, pour GDPR, HIPAA, CPRA)

- Protocoles de remédiation spécifiques à l'IA (par exemple, suppression des données non consenties des ensembles d'entraînement)

6. Auditer, valider et rapporter

Conservez une trace complète de toutes les actions automatisées et des interventions humaines.

Intégrez les rapports BigID aux plateformes SIEM/SOAR pour faciliter la production de rapports de sécurité et de conformité.

Générer des tableaux de bord en temps réel pour suivre efficacité de la remédiation et Tendances en matière de gestion des risques liés à l'IA.

7. Optimiser grâce à un retour d'information continu

Utilisez les analyses améliorées par l'apprentissage automatique de BigID pour tirer des enseignements des résultats des actions correctives passées.

Améliorer la détection des risques liés à l'IA et la réponse des agents au fil du temps.

S’aligner sur l’évolution des normes réglementaires en matière d’IA (par exemple, Loi européenne sur l'IA, Déclaration des droits de l'IA aux États-Unis, NIST RMF).

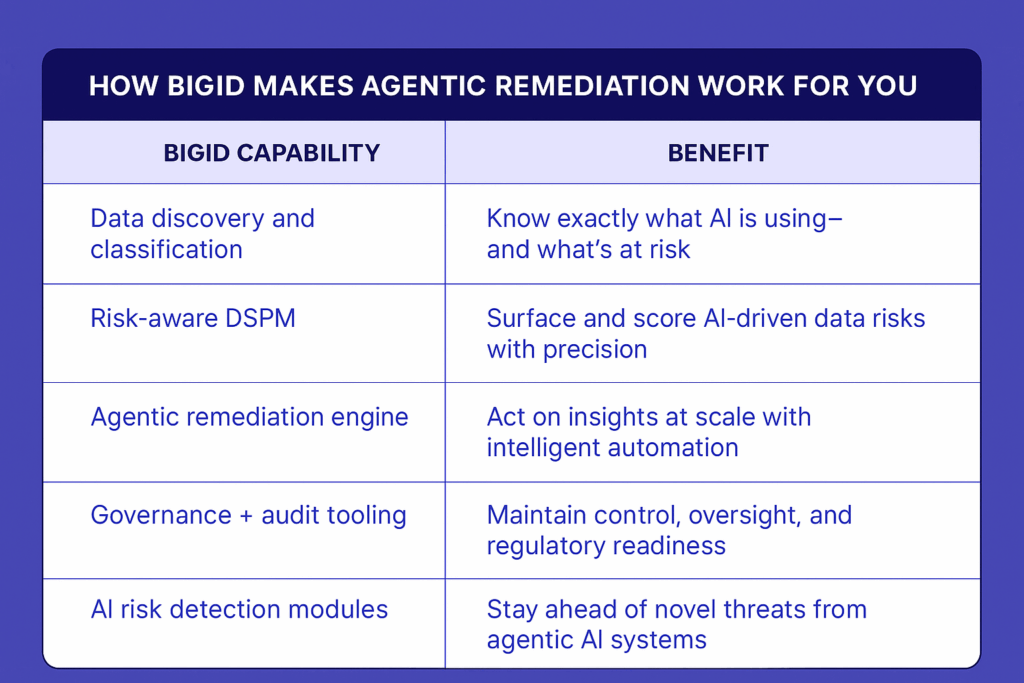

Comment BigID met la remédiation active à votre service

En résumé : BigID vous offre la visibilité, l'intelligence et le contrôle nécessaires pour non seulement gérer les risques liés à l'IA, mais aussi les anticiper. La remédiation automatisée n'est plus une option en 2026. Avec BigID, elle est intégrée.

Découvrez la remédiation par agents en action —Planifiez une démonstration individuelle avec nos experts en sécurité pour découvrir comment BigID peut réduire les risques liés à l'IA dans vos données.