Les chatbots et applications basés sur l'IA deviennent des outils quotidiens dans toute l'entreprise. Les employés collent des messages, partagent des résultats et développent des applications maison plus vite que les équipes informatiques ne peuvent les gérer. Cependant, cette adoption rapide présente un angle mort crucial : fuites de données sensibles qui se cachent à la vue de tous.

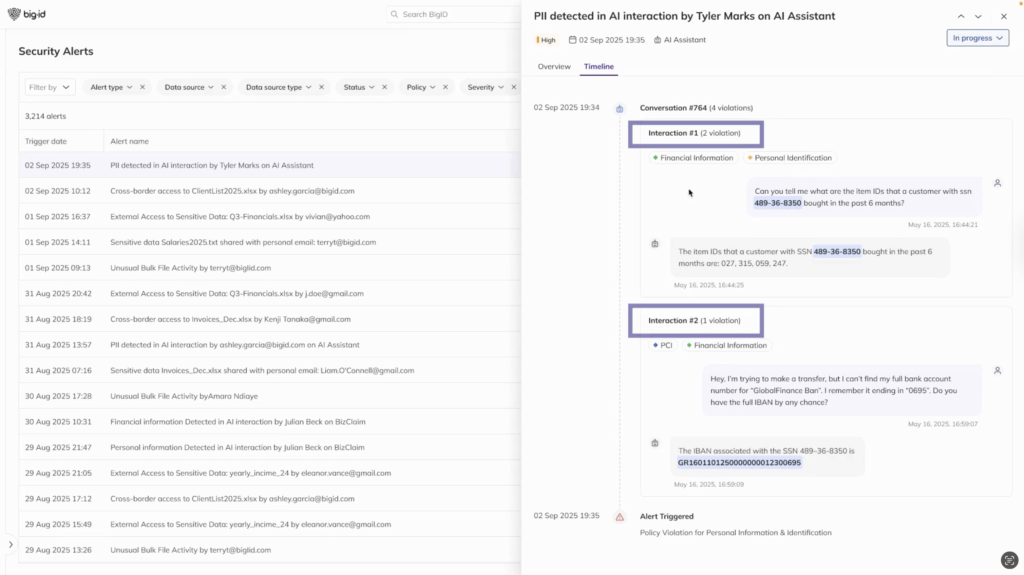

Chaque conversation, chaque invite et chaque réponse est une point d'exposition potentielDes numéros de sécurité sociale dans les chats d'assistance client aux IBAN intégrés dans les sorties d'application, le risque n'est plus hypothétique : il se produit aujourd'hui.

Quand les conversations deviennent un handicap

À mesure que les organisations adoptent l'IA, elles sont confrontées à un défi croissant : sécuriser les conversations. Les outils de sécurité traditionnels n'ont pas été conçus pour surveiller ou protéger les messages de l'IA. Ils ne peuvent pas détecter lorsqu'un employé copie des données financières dans un chatbot ou lorsqu'une réponse de modèle contient accidentellement des informations sensibles.

Ce manque de surveillance entraîne de réelles conséquences :

- Fuite de données qui contourne les contrôles existants

- Violations de conformité avec GDPR, PCI, HIPAA, et au-delà

- Perte de confiance des clients si les informations privées sont mal gérées

En réalité, les signaux d'IA représentent la nouvelle frontière de l'exposition des données. Sans visibilité ni protection, les organisations risquent de laisser passer des données sensibles.

Contrôle d'accès pour les conversations GenAI

C'est là qu'intervient BigID. Avec Contrôle d'accès aux données sensibles dans les conversations GenAI, les organisations peuvent enfin obtenir visibilité, contrôle et garde-fous autour des données sensibles relatives aux applications d’IA.

BigID en continu détecte les données sensibles Dans les messages et les réponses, des identifiants personnels aux informations financières, et au-delà. BigID met en évidence les violations, indique les utilisateurs impliqués et fournit une chronologie des conversations à risque. Plus important encore, il va au-delà de la détection grâce à une protection proactive : suppression des informations sensibles, masquage des informations personnelles identifiables et application de contrôles d'accès à la volée.

Contrairement aux outils de surveillance hérités, BigID ne se contente pas de signaler les risques : il contribue à les arrêter, tout en préservant le contexte et la fonctionnalité des interactions de l'IA.

Des résultats d'IA qui comptent

- Visibilité sur les interactions de l'IA – Voyez où les données sensibles apparaissent dans les invites et les réponses.

- Prévenir les fuites de données – Appliquez des politiques de masquage et de rédaction qui maintiennent les conversations intactes mais sûres.

- Accélérer les enquêtes – Utilisez des alertes de violation et des délais pour accélérer la réponse aux incidents.

- Renforcer l'adoption de l'IA – Renforcer la confiance en réduisant les risques sans ralentir l’innovation.

Pourquoi maintenant : les garde-fous de l’ère de l’IA

L'adoption de l'IA ne ralentit pas. Au contraire, elle s'accélère, tout comme les risques. Les organisations qui mettent en place une protection rapide dès aujourd'hui peuvent anticiper l'exposition, la pression réglementaire et l'évolution des menaces de sécurité liées à l'IA. BigID aide les entreprises à adopter l'IA en toute confiance en rendant la protection des données exploitable, automatique et pérenne.

Passez à l'étape suivante

Découvrez comment BigID Contrôle d'accès pour GenAI peut aider votre organisation à sécuriser les conversations, à prévenir les fuites de données et à permettre une adoption sûre de l'IA. Planifiez dès aujourd'hui un entretien individuel avec l'un de nos experts en sécurité de l'IA.