Données de formation Risque

-

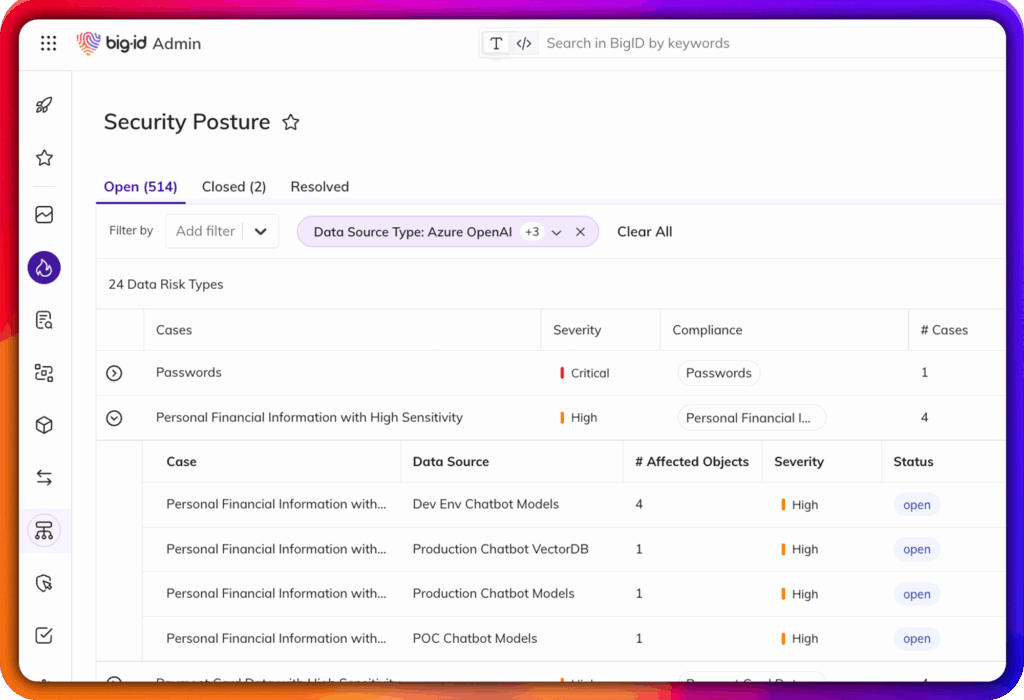

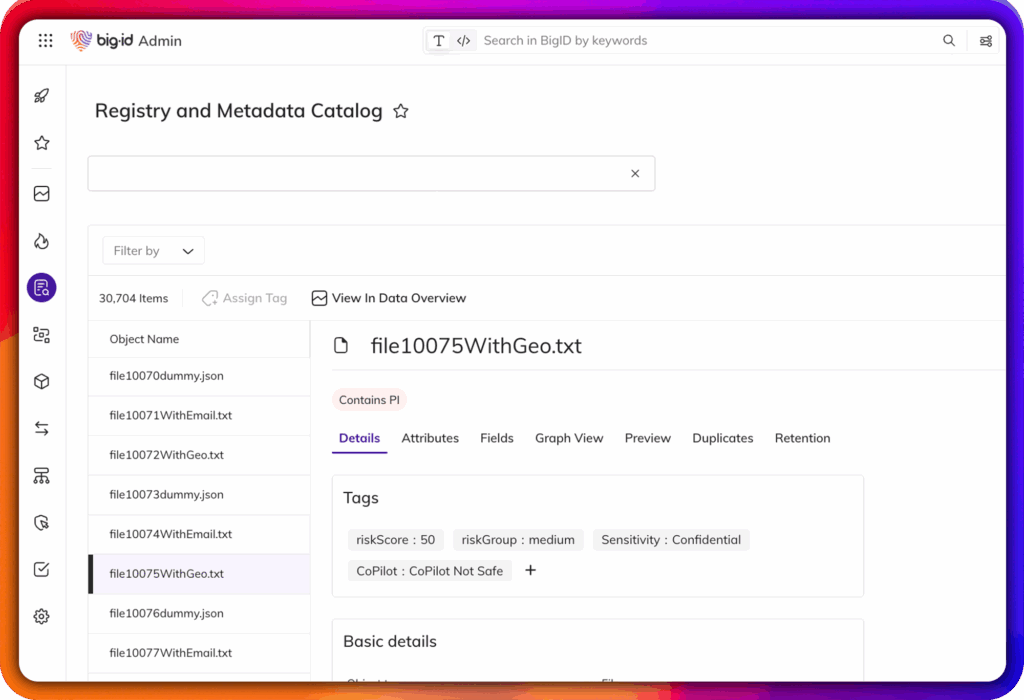

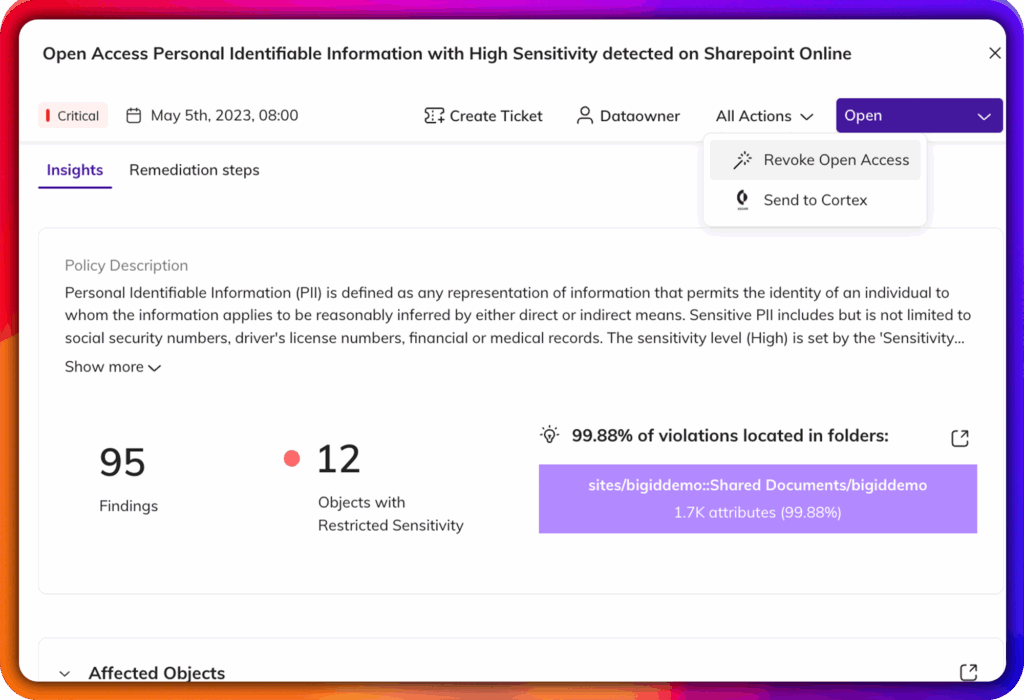

Identifier les IIP, les ISP, les informations d'identification et les IP dans les ensembles de données de formation

-

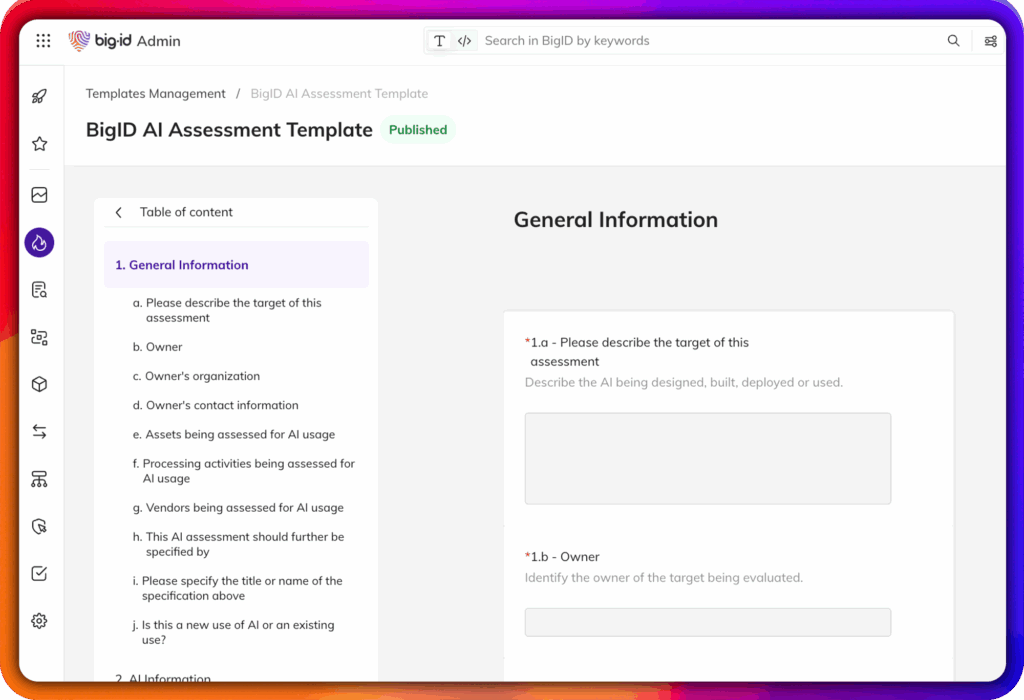

Mettre en évidence les biais, les dérives et les violations de la réglementation avant qu'ils ne soient intégrés dans le modèle.

-

Cartographier le cheminement des données brutes vers les résultats du modèle pour faciliter l'explication.