Détecter et gérer l'IA fantôme avec BigID

Dans le paysage actuel de l’IA en évolution rapide, un risque caché se développe : l’essor de IA de l'ombre— IA non autorisée, non approuvée et non gérée opérant au sein de votre organisation. Face à la prolifération d'outils d'IA sophistiqués, notamment des modèles open source ou non approuvés comme DeepSeek, vous devez obtenir une visibilité complète. C'est non seulement un avantage concurrentiel, mais aussi un impératif réglementaire. Face aux préoccupations croissantes en matière de confidentialité concernant les outils d'IA chinois et aux vastes initiatives réglementaires en vigueur dans l'UE et en Californie, vous devez savoir précisément quelle IA opère dans votre environnement.

Reconnaître les dangers des modèles d'IA open source ou non gérés

Les modèles d'IA open source et non gérés offrent un potentiel d'innovation considérable, mais ils présentent également des risques importants. Ces systèmes « fantômes » peuvent contourner vos protocoles de sécurité établis, entraînant potentiellement la fuite de données sensibles ou des failles de conformité. Par exemple, DeepSeek, un chatbot développé en Chine qui rivalise avec des modèles d'IA bien connus, a rapidement gagné en popularité, mais ses pratiques en matière de confidentialité suscitent des inquiétudes.

Des rapports récents révèlent que DeepSeek stocke les données des utilisateurs sur des serveurs en Chine, exposant ainsi votre organisation à des risques pour la sécurité nationale et la confidentialité. Les autorités de régulation italiennes et australiennes ont déjà pris des mesures pour bloquer ou restreindre l'accès à DeepSeek, invoquant un manque de transparence des données et un potentiel abus en vertu des lois chinoises sur la cybersécurité. Des analyses techniques suggèrent que ses mécanismes de connexion pourraient être liés à l'infrastructure de télécommunications publique chinoise, augmentant ainsi le risque de partage secret de données.

Lorsque des modèles malveillants s'infiltrent dans votre environnement, opérant en dehors des canaux autorisés, les vulnérabilités cachées de leur chaîne d'approvisionnement peuvent devenir dangereuses. Des modèles tiers non vérifiés peuvent s'entraîner sur des ensembles de données biaisés, voire délibérément corrompus, compromettant potentiellement votre sécurité et votre conformité.

Comprendre ce que Shadow AI signifie pour vous

L'utilisation de systèmes d'intelligence artificielle fantôme (Shadow AI) au sein de votre organisation est définie comme l'utilisation non autorisée ou non contrôlée de ces systèmes. Vous pourriez déployer ces systèmes à l'insu du service informatique ou en dehors des canaux approuvés pour répondre à des besoins opérationnels immédiats. Cependant, cette utilisation fantôme présente plusieurs risques :

- Risques de conformité : Les systèmes d’IA non approuvés pourraient ne pas répondre aux exigences réglementaires telles que Loi européenne sur l'IA ou les réglementations émergentes de l'IA en Californie, qui imposent une documentation et une surveillance détaillées pour chaque cas d'utilisation de l'IA.

- Fuite de données : Les modèles d’IA fantômes pourraient traiter des données sensibles sans protections appropriées, exposant ainsi vos informations critiques.

- Vulnérabilités de sécurité : Sans une surveillance adéquate, vous risquez de manquer des correctifs de sécurité critiques et des évaluations des risques, ouvrant ainsi la voie à des cyberattaques.

Essentiellement, Shadow AI représente une menace cachée qui peut compromettre votre efficacité opérationnelle et votre sécurité, tout en vous mettant en contradiction avec l’évolution des normes réglementaires mondiales.

Comment BigID vous aide à détecter et à gérer l'IA fantôme

La plateforme avancée d'intelligence des données de BigID vous permet d'obtenir une visibilité complète sur l'IA et de prendre des mesures décisives contre les modèles d'IA cachés ou non gérés. Vous pouvez découvrir, cartographier et gérer chaque système d'IA de votre organisation tout en respectant les réglementations et les cadres de sécurité en constante évolution. Voici comment procéder avec BigID :

1. Détecter les fichiers modèles dans les sources de données non structurées

BigID analyse automatiquement vos référentiels de données— y compris les buckets S3, les magasins de fichiers et les bases de données — pour détecter les fichiers et binaires associés aux modèles d'IA (par exemple, PyTorch, TensorFlow). Ce processus vous aide à identifier les déploiements qui ont contourné les canaux informatiques officiels, signalant ainsi les cas potentiels d'utilisation non autorisée de LLM.

2. Récupérer les e-mails pour les communications de service d'IA

BigID analyse vos systèmes de messagerie d'entreprise (Gmail, Outlook, etc.) à la recherche de messages d'inscription ou de notifications d'utilisation liés à des services d'IA externes tels que DeepSeek, OpenAI, Claude, Gemini, etc. En identifiant ces communications, vous pouvez identifier les cas où des employés pourraient utiliser des outils non autorisés, exposant potentiellement des données sensibles ou enfreindre les politiques internes.

3. Scanner les référentiels de codes

BigID étend son balayage Intégrez des fonctionnalités à vos référentiels de code. Il analyse le code source à la recherche de clés API intégrées ou d'appels à des services d'IA externes. Ce processus vous permet de détecter les intégrations non autorisées et de signaler les vulnérabilités potentielles de votre chaîne d'approvisionnement. Vous obtenez ainsi un aperçu des jeux de données utilisés et vous assurez qu'ils ne sont ni biaisés ni corrompus.

4. Surveiller les déploiements de plateformes d'IA natives

Pour les organisations utilisant des plateformes d'IA publiques (par exemple, Hugging Face, Azure AI, OpenAI, Google Cloud AI), BigID surveille les déploiements afin de classer et d'analyser les modèles sous-jacents. Vous pouvez détecter les données sensibles dans les ensembles d'entraînement, identifier les modèles non fiables contournant les canaux d'approbation standard et vérifier en continu la chaîne d'approvisionnement et les ensembles de données d'entraînement. Ce processus protège contre les biais involontaires et l'empoisonnement des données, tout en déclenchant des mesures d'application des politiques en cas d'utilisation non conforme.

5. Mapper les ensembles de données et les modèles aux ressources d'IA

BigID associe chaque ensemble de données et modèle découvert à votre inventaire d'actifs d'IA, garantissant ainsi votre conformité aux exigences telles que celles de la loi européenne sur l'IA. Cet inventaire complet vous permet de suivre chaque composant d'IA, de soutenir la gouvernance et de fournir la documentation requise par les réglementations mondiales.

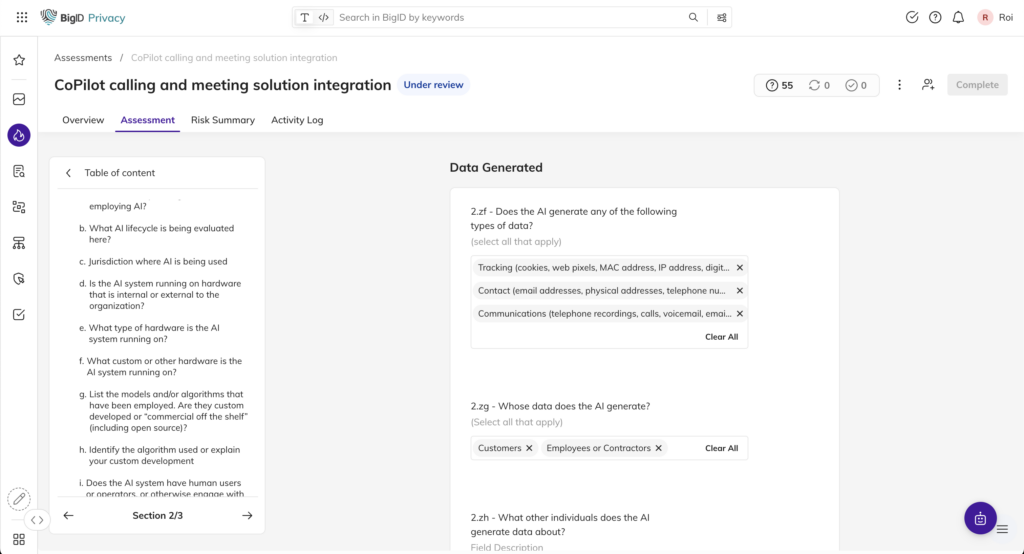

6. Lancer et gérer les évaluations des risques liés à l'IA

BigID automatise le processus d'évaluation des risques liés à l'IA en classant chaque ressource IA par rapport aux normes réglementaires. Vous maintenez un inventaire d'évaluation des risques à jour, ce qui vous permet d'identifier rapidement les risques associés à chaque modèle et de vous conformer à l'évolution de la réglementation en matière d'IA. Une fois les risques identifiés, BigID vous aide à corriger les vulnérabilités liées à la conformité et aux données. Vous pouvez nettoyer les jeux de données d'entraînement en fonction des politiques organisationnelles, appliquer des contrôles d'accès stricts et garantir que seules les utilisations autorisées persistent, atténuant ainsi les menaces potentielles avant qu'elles ne s'aggravent.

7. Carte des réglementations et des cadres de sécurité

BigID cartographie en permanence vos déploiements d'IA par rapport aux cadres de sécurité ou de confidentialité pertinents, tels que Cadre de gestion des risques liés à l'IA du NIST (AI RMF)et les exigences réglementaires. En examinant régulièrement les contrôles potentiellement défaillants, vous pouvez combler les lacunes de manière proactive et maintenir une gouvernance solide de l'IA.

Prenez le contrôle de votre paysage d'IA

À l'ère du durcissement des réglementations, de la loi européenne sur l'IA à la nouvelle législation californienne, vous devez disposer d'une stratégie robuste pour détecter et encadrer l'IA fantôme. Les systèmes d'IA non gérés peuvent vous exposer à des risques de conformité, de sécurité et de confidentialité des données, et miner la confiance que vous avez bâtie avec vos clients et les autorités de régulation.

BigID vous offre une visibilité complète et des informations exploitables pour maîtriser l'IA fantôme et mettre en place une gouvernance rigoureuse de l'IA. Grâce à nos outils avancés de détection, de surveillance et d'application des politiques, vous savez précisément quelle IA opère dans votre environnement, ce qui vous permet de gérer les risques avant qu'ils ne dégénèrent en crises.

Prêt à prendre le contrôle de votre paysage d’IA ?

Parlez à nos experts en IA dès aujourd'hui et découvrez comment les solutions innovantes de BigID peuvent vous aider à détecter et à gérer l'IA fantôme, à sécuriser votre chaîne d'approvisionnement contre les données de formation biaisées ou empoisonnées et à garder une longueur d'avance sur les exigences réglementaires mondiales.