La sécurité de l'IA dépend des données sur lesquelles elle est entraînée. Pourtant, la plupart des organisations s'appuient encore sur des ensembles de données brutes et non filtrées, riches en informations sensibles, personnelles ou réglementées. Une fois intégrées à un modèle, ces données peuvent entraîner des injections rapides, des fuites, des accès non autorisés et des risques majeurs de conformité.

BigID change cela.

Nous sommes ravis de vous présenter Nettoyage des données pour l'IA, une nouvelle capacité puissante qui aide les organisations supprimer le contenu à haut risque des ensembles de données d’IA avant qu’il ne devienne un problème. Avec ce lancement, BigID offre aux équipes de sécurité et de gouvernance un moyen de rédiger ou tokeniser données sensibles à travers des sources structurées et non structurées, aidant ainsi les équipes à construire.

Le défi : les pipelines d'IA sont des pipelines de risques

Les entreprises étendent GenAI à l'ensemble de leurs activités, mais la plupart d'entre elles ne disposent toujours pas de garde-fous pour les données qui alimentent les modèles. Cela crée un angle mort : une fois que des données sensibles entrent dans une invite, un copilote ou un ensemble d'apprentissage, il est presque impossible de les contenir.

Les équipes de sécurité ont besoin d’un moyen de nettoyer ces données avant qu’elles n’atteignent le modèle.

Jusqu’à présent, cela a été manuel, incohérent et peu fiable.

La réponse de BigID : nettoyer les données avant que l'IA ne les touche

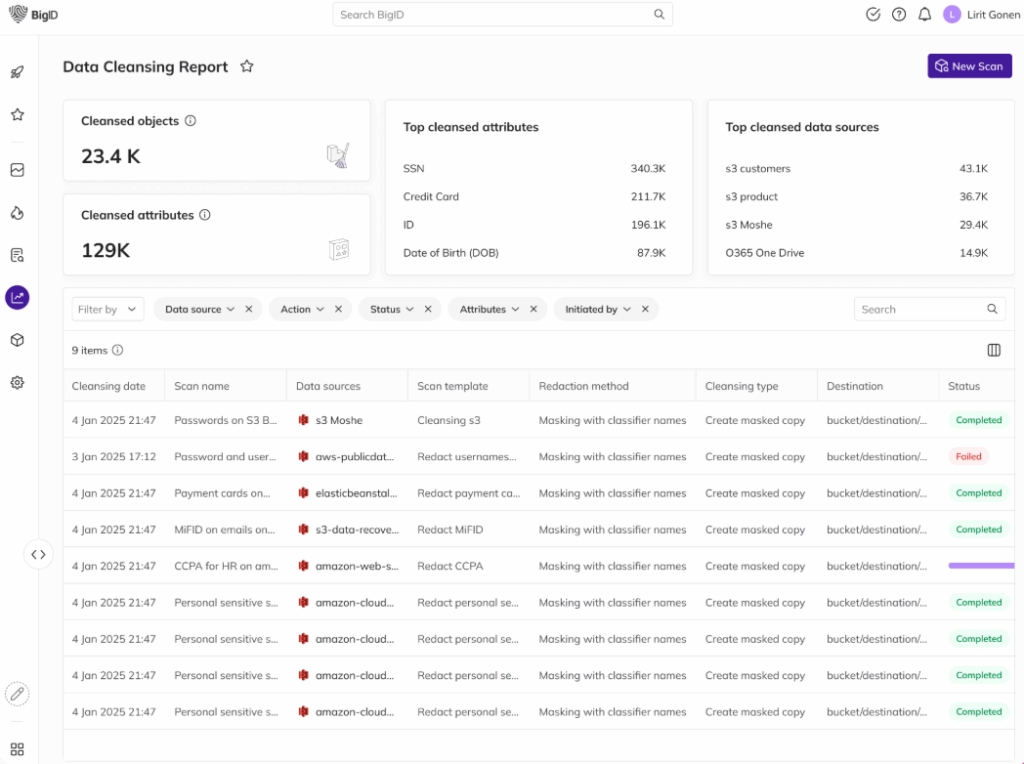

Data Cleansing for AI résout ce problème en offrant aux équipes un moyen évolutif de prétraiter les ensembles de données avec une gouvernance intégrée.

- Automatiquement détecter et classer données personnelles, sensibles ou réglementées

- Choisissez de rédiger ou tokeniser le contenu—préserver l'utilité sans exposer les risques

- Appliquer le nettoyage aux données structurées et non structurées : e-mails, PDF, documents et plus encore

- Appliquer la politique à la source, avant que les données n'entrent dans vos pipelines LLM

Le résultat ? Des ensembles de données plus propres, des risques moindres et des systèmes plus solides Posture de sécurité de l'IA.

Avantages concrets

- Prévenir les fuites de données : Empêchez l’intégration d’informations personnelles et confidentielles dans les résultats de l’IA.

- Protection contre l'injection rapide : Minimisez le risque d’injection en nettoyant les invites et les fichiers sources.

- Maintenir le contexte, pas le risque : La tokenisation préserve la structure afin que les modèles continuent d'apprendre efficacement.

- Gouverner les données non structurées : Nettoyez les données au-delà des bases de données, là où se trouve réellement le contenu le plus sensible.

- Accélérez l’utilisation de l’IA en toute confiance : Offrez aux équipes d’IA un accès plus rapide à des ensembles de données approuvés et fiables.

Pourquoi c'est important

L’IA évolue rapidement, mais la sécurité, la confidentialité et la conformité ne peuvent pas être laissées de côté.

Nettoyage des données pour l'IA fait partie du programme plus large de BigID Pipeline de données sécurisé, aidant les organisations à maîtriser les données découvertes, étiquetées et utilisées dans GenAI. C'est ainsi que les entreprises passent d'une gestion aveugle des risques à une gestion plus efficace des risques. gouvernance proactive—sans bloquer l’innovation.

Voyez-le en action

Vous voulez voir comment fonctionne le nettoyage des données pour l’IA ? Organisez dès aujourd'hui un entretien individuel avec l'un de nos experts en sécurité des données !