En AI La era ha desbloqueado innovaciones poderosas y ha creado nuevas puntos ciegos de la privacidadA medida que los modelos asimilan volúmenes masivos de datos y se integran en las interacciones cotidianas con los clientes, las organizaciones se enfrentan a un desafío apremiante: Prevenir que los datos personales queden expuestosLos sistemas de IA los memorizan o los utilizan indebidamente. Ahora se espera que los responsables de privacidad, derecho y datos protejan los datos confidenciales dentro de procesos de IA dinámicos y complejos sin obstaculizar la innovación.

El problema: los riesgos a la privacidad han superado los controles tradicionales

Los programas de privacidad tradicionales se diseñaron para entornos estáticos: bases de datos estructuradas, flujos de datos conocidos y acceso predecible. Sin embargo, los sistemas de IA no siguen estas reglas. Consumen diversos tipos de datos, a menudo carecen de trazabilidad y pueden revelar información confidencial involuntariamente mediante inferencia.

Las áreas de riesgo clave incluyen:

- Capacitación sobre conjuntos de datos sin el consentimiento o clasificación adecuados

- Modelos generativos con fugas inadvertidas PII en salidas

- IA de sombra y la experimentación descentralizada que introduce puntos ciegos

- La creciente presión regulatoria mundial (Ley de AI de la UE, CPRA, Directrices sobre inteligencia artificial del RGPD)

¿Qué ha cambiado? Los modelos de IA ya no son solo software: son sistemas basados en datos que requieren gobernanza constante y supervisión de la privacidad.

Un marco estratégico para la privacidad de los datos de IA

Para construir sistemas de IA confiables y compatibles, los programas de privacidad deben evolucionar. A continuación, se presenta un marco general para guiar este cambio:

1. Inventario de IA en toda la empresa

- Identificar dónde se está desarrollando, implementando o experimentando con IA

- Conjuntos de datos de catálogo utilizados para entrenamiento, ajuste e inferencia

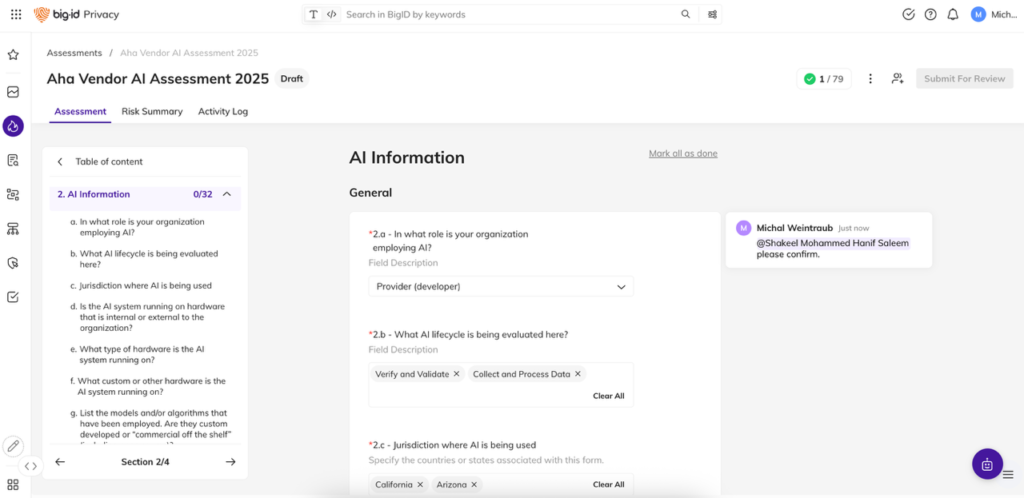

2. Integrar las revisiones de privacidad en el ciclo de vida de la IA

- Tratar la IA como un proveedor externo o una iniciativa de alto riesgo

- Introducir evaluaciones de riesgos de privacidad para conjuntos de datos y modelos desde el principio

3. Clasificar y supervisar datos relacionados con la IA

- Utilice herramientas automatizadas para etiquetar y marcar PII, PHI y otros datos regulados

- Monitorear continuamente la desviación de datos, la exposición o las violaciones de políticas.

4. Establecer y aplicar controles de datos

- Definir reglas de uso, minimización, retención y residencia.

- Aplicar la gobernanza basada en políticas en las fases de entrenamiento e inferencia

5. Construir una alineación multifuncional

- Crear una responsabilidad compartida entre la ciencia de datos, el ámbito legal, la seguridad y la privacidad.

- Capacitar a los equipos sobre los riesgos de privacidad de la IA y los procedimientos operativos estándar

BigID permite a los equipos de privacidad, legales y seguridad implementar la privacidad de la IA a gran escala.

Si bien la estrategia correcta define la visión, ejecutarla a gran escala requiere la plataforma adecuada. BigID ayuda a las organizaciones a implementar la privacidad en todos los canales de IA, lo que permite que la gobernanza sea ejecutable, detectable y auditable.

BigID le ayuda a:

- Descubra datos confidenciales en los procesos de IA: Escanee automáticamente datos estructurados y no estructurados utilizados en el entrenamiento, el ajuste y la inferencia, incluidos archivos, texto, registros y API.

- Clasificar con precisión los datos personales y regulados: Identifique PII, PHI, información financiera y otros atributos confidenciales con modelos de clasificación impulsados por IA capacitados para obtener resultados de privacidad reales.

- Aplicar políticas de minimización y retención de datos: Defina y automatice los controles para que solo se utilicen los datos correctos y se conserven solo el tiempo que sea necesario.

- Gobernar la IA en la sombra y los modelos no autorizados: Detecte actividades de IA no autorizadas, usos indebidos de datos y puntos ciegos de riesgo antes de que resulten en violaciones de cumplimiento o daños a la marca.

- Habilite la privacidad desde el diseño en todos los equipos: Proporcionar a los equipos legales y de privacidad una visibilidad continua sobre dónde se utilizan los datos, cómo se gestionan y qué políticas están vigentes sin frenar la innovación.

El resultado: Reduce la exposición, habilita una IA compatible a gran escala y genera confianza en el consumidor al proteger los datos personales desde el principio.

La privacidad no puede ser una cuestión de último momento en la IA: BigID la convierte en una ventaja incorporada.

Reserve una demostración para ver cómo BigID ayuda a proteger los datos personales en sus sistemas de IA y permite una innovación confiable y compatible a gran escala.