Agentes de IA Não são mais ferramentas experimentais confinadas a laboratórios de inovação. Elas já estão incorporadas em ambientes corporativos — lendo arquivos, respondendo a chamados, provisionamento de acesso, gerando relatórios e iniciando remediação ações em sistemas críticos. Sua adoção está se acelerando porque reduzem o atrito e automatizam a tomada de decisões em grande escala.

No entanto, muitas organizações estão implementando esses agentes sob uma premissa arriscada: a de que os controles de IAM existentes, a segurança do modelo ou as estruturas de governança de IA de alto nível sejam suficientes. Embora esses controles continuem sendo necessários, eles são fundamentalmente incompletos para sistemas autônomos que podem raciocinar, agir e acessar e movimentar dados sensíveis continuamente sem intervenção humana.

Os agentes de IA não são apenas modelos. São atores operacionais. E atores que operam na velocidade das máquinas, com acesso persistente a dados corporativos, exigem uma nova disciplina de segurança — uma baseada em dados, não apenas em identidade ou infraestrutura. Esta é a base de Gestão da postura do agente de IA.

Agentes autônomos como informantes invisíveis

As equipes de segurança são experientes na gestão de riscos humanos. Elas monitoram usuários, funções, permissões e atividades para entender quem tem acesso a quê e por quê. Esse modelo falha quando aplicado a agentes de IA.

Os agentes não fazem login interativamente, não solicitam acesso repetidamente nem encontram dificuldades ao agir. Uma vez implantados, muitos operam continuamente usando contas de serviço, aplicativos OAuth ou chaves de API — frequentemente fora das verificações de identidade tradicionais. Com o tempo, eles funcionam como usuários internos com privilégios permanentes.

Esse desafio é frequentemente apresentado como um Governança de IA problema, mas, em sua essência, é um problema de segurança de dados. O principal risco não é o agente em si, mas os dados sensíveis, regulamentados e críticos para os negócios aos quais ele pode ter acesso e sobre os quais pode agir.

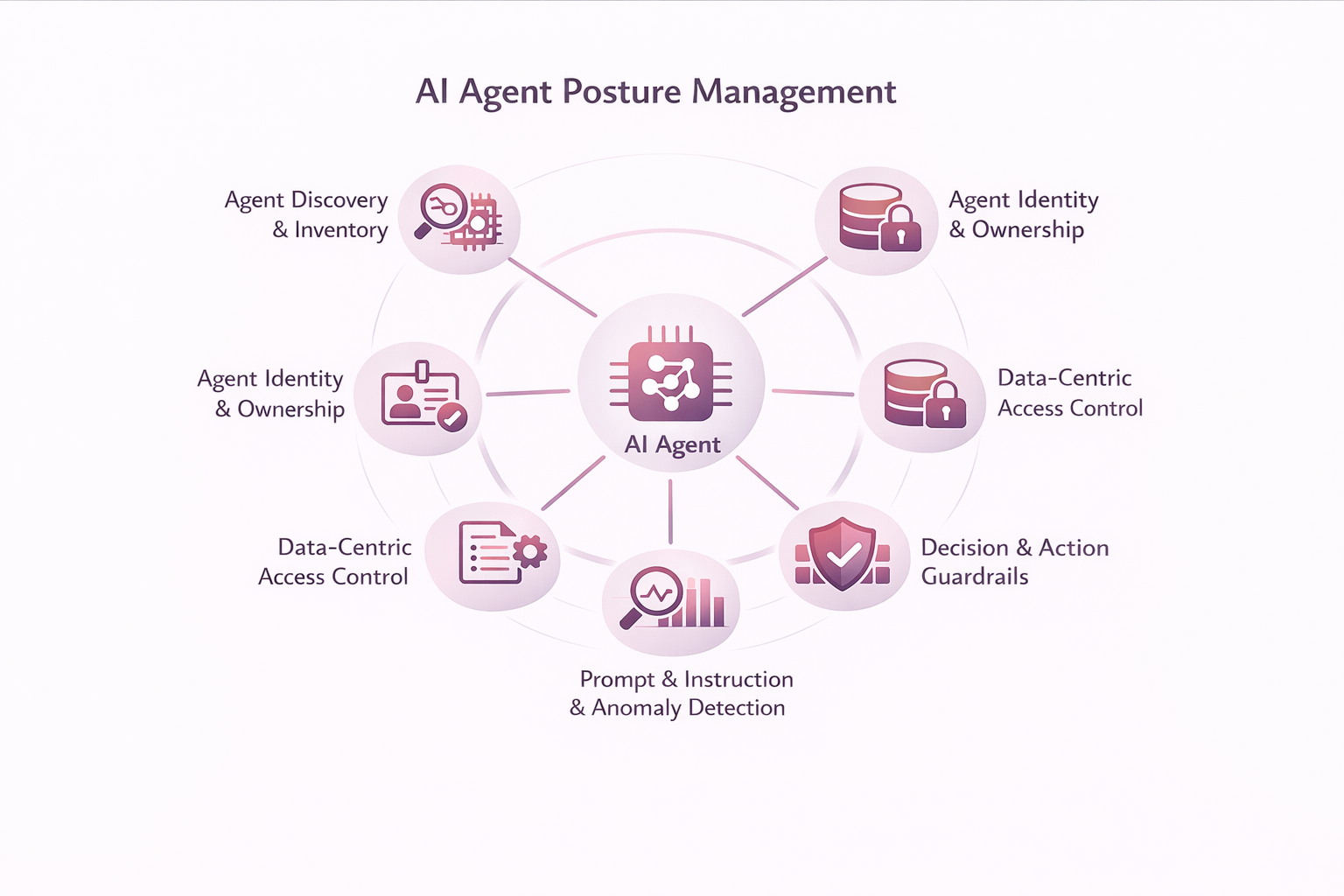

Definindo o gerenciamento da postura de agentes de IA

O Gerenciamento de Postura de Agentes de IA (AI Agent Posture Management) proporciona visibilidade, controle e governança contínuos sobre o que os agentes de IA podem acessar, decidir e fazer em relação aos dados corporativos. Ele estende o gerenciamento de postura de segurança a agentes autônomos cujo comportamento não pode ser totalmente previsto no momento da implantação.

Na prática, isso permite que os líderes de segurança respondam a perguntas que as abordagens centradas na identidade ou no modelo não conseguem abordar de forma confiável:

A que dados este agente pode aceder e que dados utiliza efetivamente? Que ações podem ser tomadas com esses dados? O comportamento da empresa ainda está alinhado com as políticas e intenções? E quando algo dá errado, suas ações podem ser explicadas, restringidas ou interrompidas?

Sem visibilidade e controle em nível de dados, essas questões permanecem sem resposta — independentemente de quão bem as identidades sejam gerenciadas ou os modelos sejam governados.

Principais capacidades do gerenciamento de postura de agentes de IA

Descoberta e inventário de agentes

A gestão da postura de agentes de IA começa com a visibilidade. As organizações não podem governar o que não conseguem ver, e a maioria das empresas não possui um inventário completo dos agentes de IA que já operam em seus ambientes.

Os agentes são criados por desenvolvedores, incorporados em plataformas SaaS, introduzidos por meio de ferramentas de automação ou habilitados por recursos de IA em aplicativos existentes. Muitos autenticam de forma não interativa e operam continuamente, ficando fora dos inventários de identidade tradicionais.

Descoberta de Agentes Estabelece as bases para a gestão de postura, identificando e inventariando continuamente agentes em toda a empresa, incluindo:

- Descoberta de agentes de IA em aplicações, serviços em nuvem e estruturas de automação

- Identificação de identidades não humanas, como entidades de serviço, aplicativos OAuth e acesso baseado em API.

- Correlação dos agentes com os dados que eles efetivamente acessam e modificam.

- Detecção de plantas não gerenciadas, dormentes ou agentes com privilégios excessivos

Sem detecção, os agentes operam como infiltrados invisíveis. Com ela, os controles de postura podem ser aplicados de forma intencional e consistente.

Identidade e propriedade do agente

Uma vez descobertos, os agentes devem ser identificados e responsabilizados. Cada agente de IA deve ser tratado como um elemento de segurança de primeira classe, com propósito e escopo definidos.

A identidade e a propriedade do agente garantem a responsabilização por meio de:

- Atribuir uma identidade única e auditável a cada agente.

- Definir um proprietário claro e um propósito comercial documentado.

- Estabelecer limites de escopo explícitos entre sistemas e domínios de dados.

A identidade por si só, porém, é insuficiente. Conhecer Quem um agente não explica que dados utiliza ou como ele se comporta ao longo do tempo—É por isso que a identidade deve ser associada ao contexto dos dados.

Classificação de Agentes e Perfil de Risco

A descoberta e a identificação, por si só, não estabelecem uma posição. Nem todos os agentes representam o mesmo risco, e as permissões, por si só, fornecem um quadro incompleto.

Classificação de Agentes e Perfil de Risco Avalia os agentes com base no comportamento observado, incluindo:

- A sensibilidade e a natureza regulamentar dos dados acessados.

- Que dados os agentes realmente leem, escrevem ou propagam?

- A abrangência do acesso em todos os sistemas e regiões.

- O nível de autonomia e autoridade de ação do agente.

Os perfis de risco devem ser atualizados continuamente à medida que os agentes evoluem. Ao fundamentar a classificação na interação de dados reais, as organizações podem concentrar os controles onde eles são mais importantes.

Controle de acesso centrado em dados

As permissões em nível de sistema são muito genéricas para agentes autônomos que interagem diretamente com informações sensíveis.

O Controle de Acesso Centrado em Dados impõe o princípio do menor privilégio na camada de dados, permitindo:

- Visibilidade do acesso específico dos agentes de dados

- Decisões de acesso sensíveis baseadas na classificação e no risco.

- Acesso vinculado a tarefas e com prazo determinado, em vez de privilégios permanentes.

Sem controles em nível de dados, as organizações não conseguem evitar a superexposição — mesmo que as identidades e permissões pareçam corretas no papel.

Diretrizes para tomada de decisão e ação

Os agentes de IA não se limitam à análise — eles agem. À medida que a autonomia aumenta, também aumenta o impacto potencial.

As diretrizes de decisão e ação definem os limites operacionais, incluindo:

- Limites explícitos às ações permitidas

- Aprovação com intervenção humana para decisões de alto risco

- Salvaguardas para ações irreversíveis, como exclusão ou compartilhamento.

- Interruptores de segurança e caminhos de reversão

A automação sem mecanismos de proteção amplifica o risco em vez da eficiência.

Governança de instruções e instruções

Os avisos e instruções aos agentes são uma superfície política crítica que influencia diretamente o comportamento.

A Governança de Instruções e Respostas permite que as organizações:

- Instruções para o agente de versão e auditoria

- Detectar desvios ou manipulações de prompts

- Separar a intenção do sistema do contexto fornecido pelo usuário.

- Aplicar políticas de dados e conformidade dentro do raciocínio do agente.

Sem visibilidade das instruções, o comportamento do agente torna-se imprevisível e incontrolável.

Monitoramento contínuo e detecção de anomalias

Os controles estáticos falham em ambientes dinâmicos. O gerenciamento de postura de agentes de IA exige visibilidade contínua do comportamento do agente.

O monitoramento contínuo e a detecção de anomalias proporcionam:

- Monitoramento contínuo do acesso aos dados e das ações.

- Estabelecimento de linha de base comportamental por agente

- Detecção de comportamento anômalo ou que viole as políticas

- Correlação com identidade, risco de dados e sinais de ameaça

Isso possibilita a intervenção precoce, antes que pequenos desvios se transformem em incidentes.

Os riscos que esta disciplina visa prevenir

Sem essas capacidades, as organizações enfrentam riscos crescentes: aumento indevido de privilégios, exfiltração silenciosa de dados por meio de fluxos de trabalho legítimos, injeção imediata de malware e perda de responsabilidade durante investigações. Quando incidentes ocorrem, atribuir os resultados à "IA" não é suficiente nem justificável.

Por que o gerenciamento de postura de agentes de IA é fundamentalmente uma questão de dados.

Grande parte do mercado se concentra em proteger modelos ou gerenciar identidades. Essas abordagens são necessárias, mas não abordam a superfície de risco mais importante: como os agentes autônomos interagem com os dados corporativos ao longo do tempo.

- Os controles que utilizam apenas a identidade não conseguem visualizar a sensibilidade dos dados nem o uso real dos mesmos.

- Os controles baseados apenas no modelo não podem governar as ações subsequentes.

Sem contexto de dados, a postura é inferida, não imposta. O gerenciamento de postura de agentes de IA deve estar fundamentado em uma base sólida. plataforma de segurança orientada a dados que compreende a sensibilidade, a exposição e a atividade dos dados em tempo real.

Como a BigID possibilita a governança orientada a dados para agentes de IA

BigID Ajuda as organizações a descobrir e classificar dados sensíveis, compreender o acesso e a exposição, monitorar a atividade dos dados e aplicar medidas corretivas baseadas em políticas em grande escala. O Gerenciamento de Postura de Agentes de IA estende essas capacidades a agentes autônomos que operam em todo o ambiente de dados.

Em vez de questionar se um modelo de IA é “seguro”, as organizações deveriam fazer uma pergunta mais prática: nossos dados continuam sendo governados quando a IA tem permissão para agir? Essa mudança é o que possibilita a adoção da IA sem sacrificar o controle.

Da governança da IA à postura do agente

Agentes de IA já operam em larga escala em ambientes corporativos. Organizações que os tratam como simples ferramentas terão dificuldades para manter o controle. Aquelas que os tratam como identidades — governadas por controles centrados em dados — escalarão a IA de forma segura e responsável.

A gestão da postura de agentes de IA não é uma consideração futura. É a próxima evolução da segurança de dados, e defini-la desde o início garante que ela evolua de acordo com as suas necessidades — e não em resposta a um incidente.

Quer saber mais? Agende uma consulta individual. com um de nossos especialistas em IA e segurança de dados.