Las fallas de seguridad de IA más peligrosas de 2026 no parecerán brechas de seguridad. Parecerán la misma rutina de siempre: modelos entrenados con datos confidenciales que nunca debieron ver, identidades no humanas con privilegios excesivos y una IA agéntica que se descontrola con datos sin gobernanza, contexto ni restricciones.

A medida que las empresas implementan la IA a gran escala, el riesgo se desplaza de la pérdida de datos al uso indebido de los mismos. Los datos confidenciales utilizados para entrenar y potenciar la IA (registros de clientes, IP, datos financieros) ahora se pueden acceder, recombinar y procesar con mayor rapidez que la intervención humana. Si a esto le sumamos las identidades no humanas no gestionadas y una Gestión de la Postura de Seguridad de la IA (AISPM) inmadura, el radio de acción se vuelve sistémico.

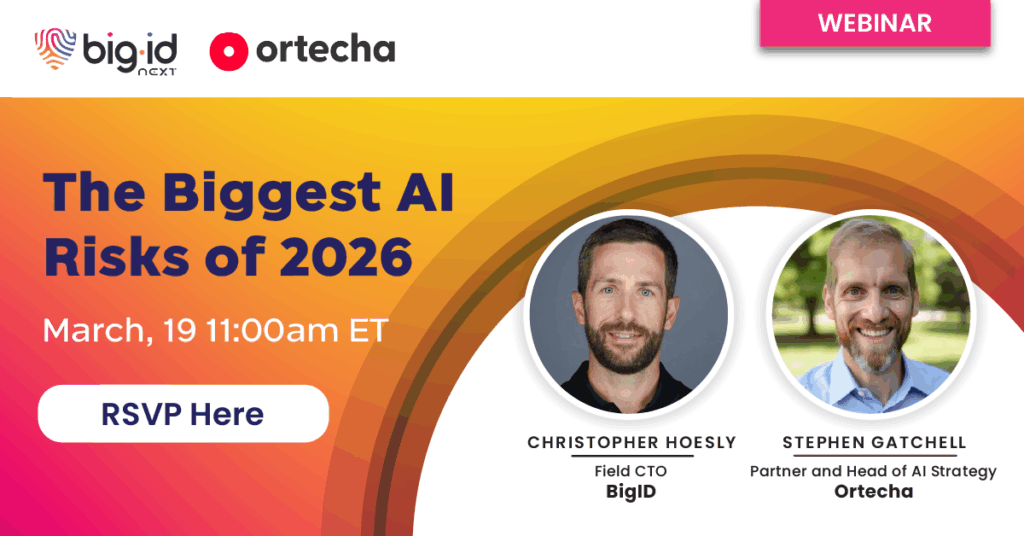

En este seminario web, analizaremos los mayores riesgos de seguridad de la IA que definirán el año 2026, entre ellos:

- Cómo los datos sensibles utilizados en el entrenamiento de IA se convierten en una responsabilidad a largo plazo

- Por qué el acceso a la identidad no humana es la superficie de riesgo de más rápido crecimiento (y menos gobernada)

- Dónde encaja (y dónde falla) el AISPM a la hora de prevenir el uso indebido en el mundo real

- Cómo los controles de acceso débiles y la mala higiene de los datos convierten a la IA en un multiplicador de fuerza del riesgo

Saldrá con un marco práctico para gobernar cómo los sistemas de IA usan los datos para que los equipos de seguridad puedan pasar de controles reactivos a la prevención proactiva del uso indebido.