AI No se trata solo de transformar su negocio, sino de redefinir las reglas del juego en materia de riesgo, confianza y gobernanza. La reciente Cumbre Digital de BigID reunió a expertos del sector para explorar los riesgos de la IA, las medidas de seguridad y las estrategias de innovación responsable, atrayendo a más de 1100 participantes deseosos de profundizar en la gobernanza de la IA y la reducción de riesgos.

La sesión principal con Allie Mellen, analista principal de Forrester Research Especializado en Seguridad y Riesgos, ofreció una perspectiva esclarecedora sobre los desafíos y las estrategias en torno a este tema. Seguridad de IA y GenAIPara los profesionales que trabajan en el ámbito de la ciberseguridad, en particular los CISO, esta ponencia principal ofreció información práctica sobre cómo las organizaciones pueden modelos de IA seguros y la infraestructura, al tiempo que se preparan para los riesgos que plantea el aumento de la demanda. agente sistemas.

El panorama de riesgos en evolución en la seguridad de la IA

Allie Mellen comenzó su charla haciendo hincapié en la naturaleza dinámica y en rápida evolución del ámbito de la seguridad de la IA. Con avances como los desarrollos en aplicaciones de IA generativa (GenAI), vulnerabilidades de hardware y el impacto de modelos como Géminis y ChatGPTLa urgencia de salvaguardar los modelos y las infraestructuras es crucial.

Mellen señaló que los ataques de IA actualmente siguen siendo de carácter académico, a menudo originados por investigadores que exploran vulnerabilidades o técnicas éticas de hacking "white hat". Sin embargo, el panorama está cambiando:

Ahora eso va a cambiar. Veremos que estos ataques se intensifican considerablemente… y se centran mucho más no solo en los modelos en sí, sino también en los datos subyacentes y la infraestructura que los rodea.

Vulnerabilidades y amenazas clave

Uno de los segmentos más convincentes de la ponencia principal fue la revisión que hizo Mellen de... Las 10 principales amenazas de OWASP para los modelos de lenguaje grandes (LLM) y GenAI aplicaciones. Estas amenazas ponen de relieve posibles vías de ataque en cada capa de los sistemas GenAI, resaltando vulnerabilidades que los CISO deben abordar.

Amenazas de OWASP GenAI:

- Ataques de inyección rápida: Ser capaz de entrar en una línea de comandos e inyectar algo en ella que te dé un resultado que de otro modo no podrías obtener.

- Divulgación de información confidencial: Los sistemas de IA, especialmente aquellos integrados con API o conjuntos de datos externos, pueden exponer inadvertidamente datos privados o de propiedad exclusiva.

- Envenenamiento de modelos/datos: Al manipular los datos de entrenamiento u operativos, los atacantes pueden corromper la base de conocimientos subyacente de un sistema, lo que conduce a la desinformación o a una mala toma de decisiones.

- Agentes de IA con privilegios excesivos: Un tema recurrente en la seguridad de la IA es la importancia de mantener un control estricto sobre los permisos de los agentes:

Debemos garantizar un conjunto mínimo de permisos, capacidades mínimas, herramientas y capacidad de toma de decisiones para los agentes de IA.

Riesgos en los sistemas de agentes de IA

Los agentes de IA —la creciente tendencia hacia sistemas capaces de actuar y tomar decisiones de forma independiente— presentan riesgos sustanciales. Mellen dividió estos riesgos en categorías tangibles que las organizaciones deberían evaluar meticulosamente:

- Secuestro de objetivos e intenciones: Los atacantes pueden manipular agentes de IA para subvertir su propósito original.

- Corrupción cognitiva y de la memoria: Envenenar los datos o la memoria de los modelos de IA puede provocar fallos importantes, desinformación y errores operativos.

- Agencia sin restricciones: La concesión de permisos excesivos a los agentes de IA podría exacerbar la superficie de ataque, dejando los sistemas vulnerables a acciones o decisiones no autorizadas.

- Fuga de datos: La prevención de la pérdida de datos (DLP) es fundamental para Proteger la información confidencial compartida o generada por agentes de IA, particularmente cuando se comunican externamente.

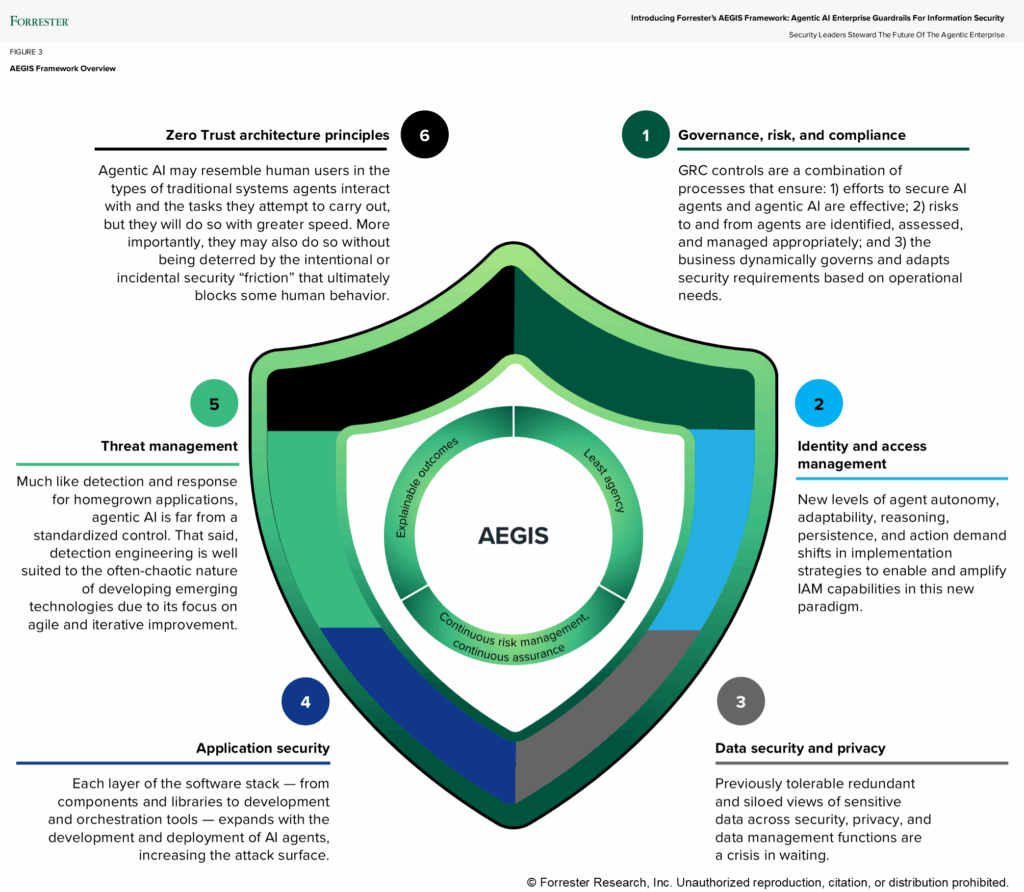

Marcos de referencia y mejores prácticas: El marco Aegis

Luego, Mellen presentó el Marco Aegis: Directrices de IA para la seguridad de la información —como un enfoque proactivo para gestionar los riesgos de la IA. El marco proporciona tres principios básicos que los CISO deberían integrar en su hoja de ruta de seguridad de la IA:

- Menor agencia: Asegúrese de que los agentes de IA estén equipados únicamente con los permisos y el acceso mínimos necesarios para ejecutar tareas específicas.

- Gestión continua del riesgo: Establecer un marco sólido de gestión de riesgos para monitorear, evaluar y mitigar los riesgos en tiempo real.

- Barreras y gobernanza: Implementar políticas y procedimientos estrictos para controlar las acciones que pueden realizar los agentes de IA, así como sus comunicaciones dentro de los sistemas internos y externamente:

La monitorización regular del modelo, la validación de entradas/salidas y las medidas de seguridad del modelo... todo ello debe estar integrado en su proceso para garantizar la seguridad.

Fortalecimiento del conocimiento y la gobernanza organizacional

Más allá de las implementaciones técnicas, Mellen destacó la importancia de la educación y la transformación cultural dentro de las organizaciones. Los líderes de seguridad deben dejar de ser percibidos como obstáculos para convertirse en asesores de confianza que impulsen la innovación.

Adopten la [IA] y dejen muy claro a la organización que están adoptando, comprendiendo y valorando ese uso de la IA.

Educar a las partes interesadas ajenas al ámbito de la seguridad, como los científicos de datos, es fundamental para fomentar la higiene y las buenas prácticas de seguridad. Mellen animó a los CISO y a los equipos de seguridad a crear un entorno abierto donde se valoren las consultas sobre IA.

Además, empoderar a los responsables de seguridad dentro de los equipos de ciencia de datos puede ayudar a cerrar la brecha entre la innovación técnica y la implementación segura.

Integrando todos los elementos: Confianza cero e IA defensiva

A medida que se expanden las capacidades de la IA, Implementación de los principios de confianza cero es esencial:

La idea de menor privilegio va a ser algo que te ayudará significativamente.

El uso defensivo de la IA fue otro pilar fundamental de la sesión de Mellen. Las organizaciones deben aprovechar las ventajas de la IA para detectar y contrarrestar las amenazas que esta genera. Desde comprender las campañas de phishing automatizadas con IA hasta gestionar las amenazas internas mediante una sólida gestión de identidades y accesos, las defensas proactivas son cruciales.

Tenemos que usar la IA para defendernos de los ataques que utilizan IA. No hay otra opción.

Dónde entra en juego BigID

Para los CISO y los equipos de seguridad, proteger la IA comienza con proteger los datos. Todo modelo de IA, ya sea desarrollado internamente o adquirido, depende de datos que deben descubrirse, clasificarse, gestionarse y protegerse con precisión. Ahí es donde BigID marca la diferencia.

BigID proporciona a los responsables de seguridad la visibilidad, el control y la inteligencia necesarios para proteger los datos que impulsan la IA. La plataforma descubre y clasifica automáticamente todos los datos confidenciales, regulados y de propiedad exclusiva en la nube, en entornos locales y en los flujos de IA, de modo que los equipos pueden identificar qué datos se utilizan, por dónde fluyen y quién puede acceder a ellos.

Con las capacidades de seguridad de datos con IA de BigID, las organizaciones pueden:

- Localiza y protege los datos confidenciales y la IA. en conjuntos de entrenamiento de modelos e interacciones entre agentes, antes de que surjan riesgos de exposición.

- Detectar y prevenir la fuga de datos con políticas de clasificación y contextuales avanzadas que se alinean con confianza cero principios; protección inmediata; y salvaguardas contra los riesgos de la IA

- Gestionar el acceso a los datos con controles precisos para garantizar el mínimo privilegio para los agentes de IA y aplicar la minimización de datos a los que la IA puede acceder.

- Supervisar y auditar los flujos de datos de IA para detectar anomalías, configuraciones erróneas o datos ocultos que aumenten el riesgo.

- Operacionalizar la gobernanza de la IA alineando las políticas de seguridad, privacidad y cumplimiento entre equipos y tecnologías.

BigID ayuda a las empresas a construir las bases para IA segura y responsable – fortalecer la confianza, minimizar el riesgo y acelerar la innovación con confianza.

En resumen: antes de poder proteger la IA, necesita proteger sus datos. BigID lo hace posible.

La ponencia de Allie Mellen instó a los líderes de seguridad a replantearse su enfoque de la seguridad de la IA. Al aprovechar marcos como Aegis e implementar soluciones de líderes del sector como BigID, las organizaciones pueden proteger su innovación basada en IA y, al mismo tiempo, gestionar los riesgos de los sistemas automatizados y las aplicaciones de IA general. En un mundo cada vez más definido por la toma de decisiones impulsada por la IA, estas medidas no son solo opciones, sino necesidades.

¿Te perdiste la charla en directo? Mantente al tanto de las novedades. eventos futuros o Demostración individual programada para garantizar la seguridad de su programa de IA a futuro.