En 2025, las empresas superaron un umbral crítico. La IA dejó de ser un asistente pasivo y se convirtió en un actor clave en los flujos de trabajo empresariales: generando código, emitiendo alertas, planificando acciones e incluso integrando herramientas por sí sola. Esta nueva clase de sistemas de IA, denominada IA agente—crea oportunidades y riesgos a una escala sin precedentes. Casi todas las industrias se enfrentan a preguntas como ¿Cómo confiamos en los sistemas autónomos? y ¿Cómo cerramos los puntos ciegos de seguridad que las herramientas tradicionales no pueden ver? La respuesta para los equipos con visión de futuro es Remediación agente—una nueva clase de controles que cierra el ciclo entre la detección y la acción en los programas de seguridad de datos. Esta guía le ofrece una comprensión completa de qué es la remediación agentica, por qué es importante y cómo se relaciona con... Gestión de posturas de seguridad de datos (DSPM), y cómo ponerlo en práctica sin perder de vista los riesgos.

¿Qué es la remediación agente? Una definición clara

La remediación agética se refiere al uso de la propia IA agética para identificar, priorizar y ejecutar acciones de reducción de riesgos en todo el patrimonio de datos con una mínima sobrecarga manual. Va más allá de los flujos de trabajo reactivos actuales, donde los equipos detectan riesgos, pero aún tienen dificultades para solucionarlos de forma consistente y a escala.

Piense en la remediación agente como:

- IA que no solo detecta exposiciones de datos riesgosas, sino que también sugiere (y puede llevar a cabo) acciones seguras.

- Un sistema que aprende continuamente del contexto para priorizar primero las soluciones más impactantes.

Esto no es simplemente una automatización programada. Es adaptado, contextualy guiados por inteligencia de datos profunda.

Por qué la remediación agente es crucial en 2026

La IA agente está ahora en todas partes, desde los generadores de código hasta los flujos de trabajo de seguridad en la nube. Pero esa misma autonomía introduce nuevos riesgos que las herramientas de detección tradicionales no pueden abordar:

1. Creciente superficie de ataque de los agentes autónomos

Los sistemas de IA agenticos ejecutan planes de varios pasos, utilizan herramientas y toman decisiones sin intervención humana. Esta capacidad aumenta el número de posibles puntos de fallo y vectores de explotación. Los investigadores demuestran que la toma de decisiones independiente, la memoria persistente y la integración de herramientas en los sistemas agenticos generan riesgos de seguridad que van mucho más allá de las vulnerabilidades clásicas de la IA.

2. Las amenazas autónomas están aumentando

Los ciberdelincuentes ya están utilizando IA de agentes para automatizar ataques a gran escala (desde phishing hasta explotación continua), como se ve en las recientes advertencias de la industria sobre “crimen de vibraciones”" y operaciones adversarias automatizadas de IA.

3. Las herramientas tradicionales fallan ante los puntos ciegos de la agencia

Las herramientas de seguridad tradicionales, como la prevención de pérdidas de datos (DLP) clásica y la automatización basada en reglas, carecen de la conciencia contextual necesaria para comprender la importancia de una acción o cómo responder de forma inteligente cuando los agentes de IA acceden a datos confidenciales. DSPM ofreció la primera capa de visibilidad y clasificación; la remediación agética ofrece... Respuesta procesable acoplada al razonamiento de IA.

DSPM y remediación agente: una relación estratégica

Para comprender la remediación agente, primero debe comprender la Gestión de la Postura de Seguridad de Datos (DSPM).

¿Qué hace DSPM?

DSPM descubre, inventaría y clasifica datos confidenciales en entornos multicloud, SaaS e híbridos, lo que permite a los equipos ver dónde reside el riesgo y quién tiene acceso.

DSPM responde preguntas críticas:

- ¿Qué datos sensibles existen?

- ¿Dónde se almacena?

- ¿Quién puede acceder?

- ¿Qué impacto tiene en el cumplimiento?

Sin embargo, el DSPM por sí solo aún deja una brecha de ejecución. Ahí es donde remediación agente Entra.

Cómo la remediación agente completa el ciclo de vida

La remediación agentiva se basa en DSPM al agregar:

- Priorización de riesgos impulsada por IA basado en contexto real.

- Sugerencias de remediación guiada Adaptado a su entorno.

- Ejecución semiautónoma o totalmente automatizada de correcciones.

BigID combina de forma única DSPM y remediación agenética De esta manera, no sólo se ve el riesgo, sino que se reduce con resultados mensurables.

Casos de uso reales: de la teoría al impacto

A continuación se presentan situaciones prácticas en las que la remediación agente brilla:

1. Respuesta automática a la exposición de datos confidenciales

Su equipo descubre que datos empresariales confidenciales se comparten ampliamente en aplicaciones SaaS. En lugar de generar tickets manualmente y realizar ciclos de revisión, la remediación con agentes sugiere configuraciones seguras y puede implementarlas automáticamente, reduciendo el tiempo de reparación de días a horas.

2. Correcciones a errores de configuración de la nube

Una política de IAM de alto riesgo aplica derechos excesivamente permisivos. La remediación agente analiza el contexto, prioriza el riesgo y sugiere acciones correctivas precisas que cumplen con sus políticas de gobernanza.

3. Gobernanza de IA y prevención de pérdida de datos para copilotos

DSPM para IA Identifica solicitudes de datos riesgosas enviadas a herramientas generativas externas. La remediación agente correlaciona las tendencias de uso y corrige los riesgos de sobrecompartir datos antes de que se conviertan en infracciones de cumplimiento.

Riesgos en la operacionalización de la IA agencial y cómo evitar los puntos ciegos

La remediación agente implica poder, y con él, responsabilidad. A continuación, se presentan los riesgos clave y cómo gestionarlos:

1. Acciones deshonestas o equivocadas

Los agentes autónomos podrían tomar medidas que contradigan las políticas. Aplique siempre las barreras de gobernanza y los flujos de trabajo de escalamiento para que las acciones de alto impacto requieran la aprobación humana.

2. Sugerencias de solución incorrectas

La IA puede alucinar o malinterpretar el contexto. Asegúrese de que su sistema combine las sugerencias de la IA con inteligencia de datos real y un contexto de clasificación profundo.

3. Cadenas de datos invisibles

La remediación agente no puede solucionar lo que no puede ver. Invierta en el descubrimiento continuo de DSPM en todos los entornos y tipos de datos.

4. Requisitos de gobernanza y auditoría

Documente cada acción de la agencia con registros y registros de auditoría. Este nivel de visibilidad facilita la preparación para auditorías y la validación continua del cumplimiento.

Respaldo de la investigación y señales de la industria

Los marcos industriales y las investigaciones de seguridad validan estas tendencias:

- OWASP liberado Las 10 principales amenazas y guías de mitigación específicas para la seguridad de la IA con agentes, destacando las amenazas únicas que plantean los sistemas autónomos.

- McKinsey y otros líderes de opinión sobre riesgos describen los marcos de seguridad en capas como esenciales para Implementación segura de IA mediante agentes.

- Las empresas de análisis están siguiendo la convergencia de DSPM, DLPy Seguridad de la IA en plataformas unificadas basadas en inteligencia.

Hoja de ruta operativa para 2026 y años posteriores

Para escalar con éxito la remediación mediante agentes:

Paso 1: Visibilidad de DSPM de referencia

Asegúrese de tener un inventario de datos completo, clasificación y contexto de acceso en todo su patrimonio.

Paso 2: Incorporar la priorización guiada por IA

Habilite la priorización agente para saber qué riesgos son más importantes.

Paso 3: Definir rutas de ejecución seguras

Crear políticas que codifiquen cuándo la IA puede remediar de forma autónoma y cuándo se requiere la aprobación humana.

Paso 4: Retroalimentación y validación continuas

Revisar periódicamente las acciones de remediación y los resultados para refinar la lógica de decisión de la agencia.

Paso 5: Alinearse con las necesidades del auditor y de cumplimiento

Mantener prueba de control y historial de remediación para respaldar las necesidades regulatorias.

Plan de acción de BigID: Implementar la remediación agente con confianza

1. Establecer una visibilidad profunda de los datos

Desplegar DSPM de BigID a través de entornos híbridos, multicloud y SaaS descubrir y clasificar datos sensibles, regulados y de propiedad exclusiva.

Realice un inventario continuo de los activos de datos relevantes para la IA, como conjuntos de datos de entrenamiento, entradas de indicaciones, salidas y datos ocultos utilizados por los agentes de IA.

2. Mapee el riesgo de la IA en sus datos

- Utilice la IA de BigID mapeo de datos Capacidades para detectar:

- Artefactos de datos generados por IA

- Uso de LLM de terceros

- Los datos fluyen hacia herramientas de IA generativa

3. Priorizar los riesgos con inteligencia contextual

- Aproveche Puntuación de riesgo contextual de BigID Clasificar las amenazas por:

- Impacto empresarial

- Exposición regulatoria

- Participación del sistema de IA

4. Activar flujos de trabajo de remediación de Agentic

- Configurar automatizado o políticas de remediación guiadas para:

- Datos sobreexpuestos en herramientas de colaboración

- Derechos tóxicos en entornos de nube y SaaS

- Acceso inadecuado a los conjuntos de entrenamiento de IA

5. Establecer barreras de gobernanza

- Utilice el motor de políticas de BigID para aplicar:

- Límites de remediación basados en roles

- Flujos de trabajo de remediación alineados con el cumplimiento (por ejemplo, para GDPR, HIPAA, CPRA)

- Protocolos de remediación específicos de IA (por ejemplo, eliminar datos no consentidos de los conjuntos de entrenamiento)

6. Auditar, validar e informar

Mantener un registro de auditoría completo de todas las acciones de los agentes y las anulaciones humanas.

Integre informes de BigID con plataformas SIEM/SOAR para respaldar los informes de seguridad y cumplimiento.

Genere paneles de control en tiempo real para realizar el seguimiento eficacia de la remediación y Tendencias de la postura de riesgo de la IA.

7. Optimice con retroalimentación continua

Utilice el análisis mejorado con ML de BigID para aprender de los resultados de remediación anteriores.

Mejore la detección de riesgos de la IA y la respuesta de los agentes a lo largo del tiempo.

Alinearse con los estándares regulatorios en evolución para la IA (por ejemplo, Ley de AI de la UE, Carta de Derechos de la IA en EE. UU., NIST RMF).

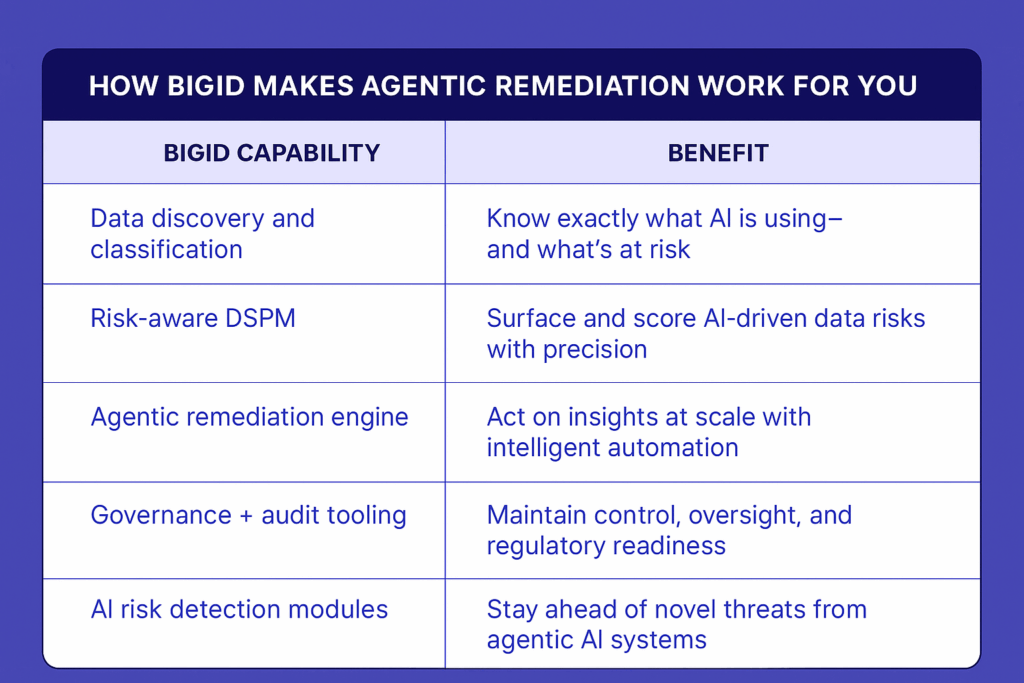

Cómo BigID hace que la remediación con agentes funcione para usted

En resumen: BigID le brinda la visibilidad, la inteligencia y el control necesarios no solo para mantenerse al día con los riesgos impulsados por la IA, sino también para anticiparse a ellos. La remediación agéntica no es opcional en 2026. Con BigID, está integrada.

Vea la remediación agente en acciónPrograme una demostración individual con nuestros expertos en seguridad para explorar cómo BigID puede reducir el riesgo impulsado por IA en sus datos.