IA Não se trata apenas de transformar o seu negócio – trata-se de reescrever as regras para risco, confiança e governança. O recente BigID Digital Summit reuniu especialistas do setor para explorar os riscos da IA, medidas de segurança e estratégias de inovação responsável, atraindo mais de 1.100 participantes ávidos por se aprofundarem na governança da IA e na redução de riscos.

A sessão principal com Allie Mellen, Analista Principal da Forrester Research Especializado em Segurança e Risco, ofereceu uma perspectiva esclarecedora sobre os desafios e estratégias relacionados. Segurança de IA e GenAIPara profissionais que atuam na área de cibersegurança, especialmente CISOs, esta palestra apresentou insights práticos sobre como as organizações podem modelos de IA seguros e infraestrutura, ao mesmo tempo que se prepara para os riscos representados por uma crescente agente sistemas.

O cenário de riscos em constante evolução na segurança da IA

Allie Mellen iniciou sua apresentação enfatizando a natureza dinâmica e em rápida evolução do cenário de segurança da IA. Com desenvolvimentos como os avanços em aplicações de IA Generativa (GenAI), vulnerabilidades de hardware e o impacto de modelos como Gêmeos e ChatGPTA urgência de salvaguardar modelos e infraestruturas não pode ser subestimada.

Mellen destacou que os ataques de IA atualmente permanecem no âmbito acadêmico, frequentemente originados de pesquisadores que exploram vulnerabilidades ou técnicas éticas de hacking ("white hat"). No entanto, esse cenário está mudando:

Isso vai mudar. Veremos esses ataques aumentarem bastante… muito mais focados não apenas nos modelos em si, mas também nos dados subjacentes e na infraestrutura que os envolve.

Principais vulnerabilidades e ameaças

Um dos segmentos mais convincentes da palestra principal foi a análise de Mellen sobre o As 10 principais ameaças da OWASP para Modelos de Linguagem de Grande Porte (LLMs) e GenAI. aplicações. Essas ameaças destacam possíveis vias de ataque em todas as camadas dos sistemas GenAI, evidenciando vulnerabilidades que os CISOs devem abordar.

Ameaças do OWASP GenAI:

- Ataques de injeção imediata: Ser capaz de acessar um prompt e inserir algo nele que produza uma saída que você não conseguiria obter de outra forma.

- Divulgação de informações sensíveis: Os sistemas de IA, especialmente aqueles integrados com APIs ou conjuntos de dados externos, podem inadvertidamente expor dados privados ou proprietários.

- Envenenamento de modelo/dados: Ao adulterar dados de treinamento ou operacionais, os invasores podem corromper a base de conhecimento subjacente de um sistema, levando à desinformação ou à tomada de decisões equivocadas.

- Agentes de IA com privilégios excessivos: Um tema recorrente na segurança da IA é a importância de manter um controle rigoroso sobre as permissões dos agentes:

Precisamos garantir um conjunto mínimo de permissões, capacidades mínimas, ferramentas e capacidade de tomada de decisão para agentes de IA.

Riscos em sistemas de IA com agentes

Os agentes de IA – a crescente tendência em direção a sistemas capazes de ação e tomada de decisões independentes – apresentam riscos substanciais. Mellen dividiu esses riscos em categorias tangíveis que as organizações devem avaliar meticulosamente:

- Sequestro de Objetivos e Intenções: Os atacantes podem manipular agentes de IA para subverter seu propósito original.

- Corrupção cognitiva e da memória: Envenenar os dados ou a memória de modelos de IA pode levar a falhas significativas, desinformação e erros operacionais.

- Agência irrestrita: A concessão excessiva de permissões a agentes de IA pode exacerbar a superfície de ataque, deixando os sistemas vulneráveis a ações ou decisões não autorizadas.

- Vazamento de dados: A prevenção contra perda de dados (DLP) é fundamental para proteger informações sensíveis compartilhadas ou geradas por agentes de IA, especialmente quando se comunicam externamente.

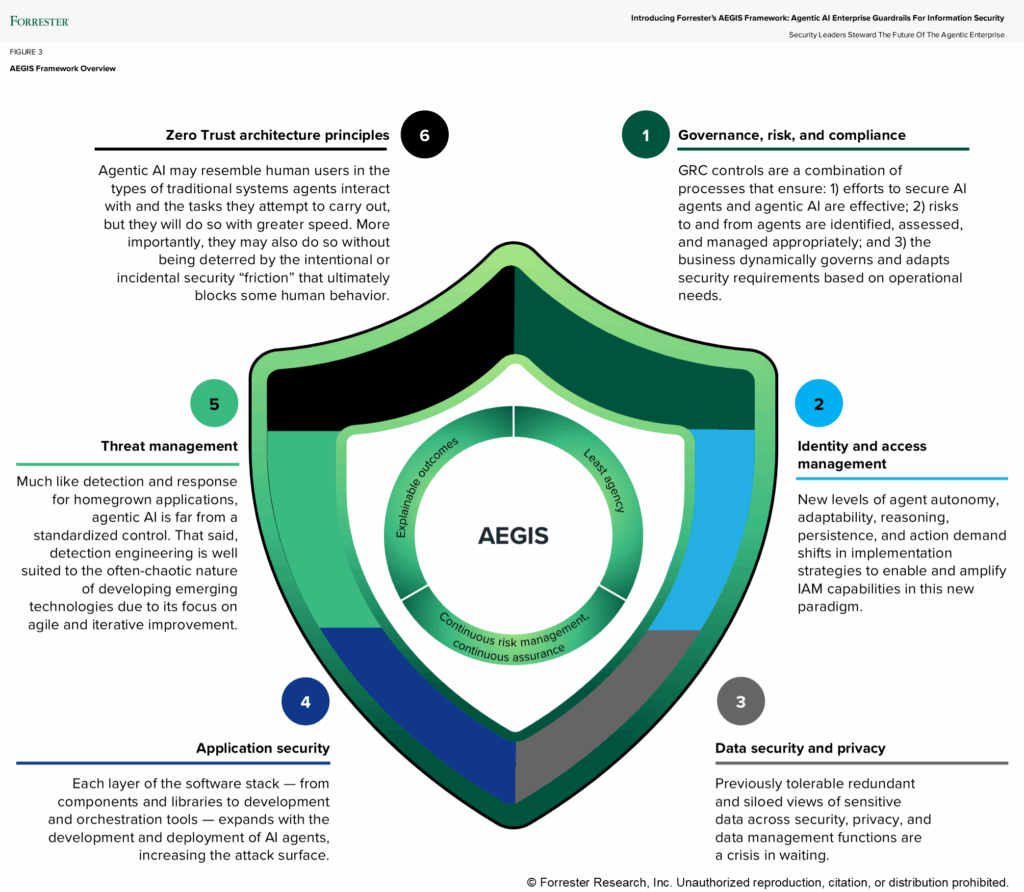

Estruturas e Melhores Práticas: A Estrutura Aegis

Mellen então apresentou o Aegis Framework – Diretrizes de IA Agencial para Segurança da Informação – como uma abordagem proativa para lidar com os riscos da IA. A estrutura fornece três princípios fundamentais que os CISOs devem integrar em seu roteiro de segurança de IA:

- Agência Mínima: Garanta que os agentes de IA possuam apenas as permissões e o acesso mínimos necessários para executar tarefas específicas.

- Gestão contínua de riscos: Estabelecer uma estrutura robusta de gestão de riscos para monitorar, avaliar e mitigar riscos em tempo real.

- Diretrizes e Governança: Implementar políticas e procedimentos rigorosos para controlar as ações que os agentes de IA podem realizar, bem como suas comunicações dentro dos sistemas internos e externamente:

Monitoramento regular do modelo, validação de entrada/saída e mecanismos de proteção do modelo... tudo isso deve ser incorporado ao seu processo para garantir a segurança.

Fortalecimento do conhecimento e da governança organizacional

Além das implementações técnicas, Mellen enfatizou a importância da educação e da transformação cultural dentro das organizações. Os líderes de segurança precisam deixar de ser vistos como obstáculos e passar a ser consultores confiáveis que defendem a inovação.

Abrace a [IA] e deixe bem claro para a organização que você está adotando, entendendo e valorizando esse uso da IA.

Educar as partes interessadas que não são da área de segurança, como cientistas de dados, é vital para promover a higiene de segurança e as melhores práticas. Mellen incentivou os CISOs e as equipes de segurança a criarem um ambiente aberto onde perguntas sobre IA sejam bem-vindas.

Além disso, capacitar especialistas em segurança dentro das equipes de ciência de dados pode ajudar a preencher as lacunas entre a inovação técnica e a implementação segura.

Unindo Tudo: Confiança Zero e IA Defensiva

À medida que as capacidades da IA se expandem, Implementando os princípios de confiança zero É essencial:

A ideia de privilégio mínimo Isso vai ser algo que te ajudará significativamente.

O uso defensivo da IA foi outro pilar da sessão de Mellen. As organizações devem aproveitar os pontos fortes da IA para detectar e neutralizar ameaças que utilizam IA. Desde a compreensão de campanhas de phishing com IA até o gerenciamento de ameaças internas por meio de um gerenciamento robusto de identidade e acesso, as defesas proativas são essenciais.

Precisamos usar IA para nos defendermos de ataques que utilizam IA. Não há outra opção.

Onde o BigID entra em cena

Para CISOs e equipes de segurança, proteger a IA começa com a proteção dos dados. Todo modelo de IA — seja desenvolvido internamente ou adquirido — depende de dados que devem ser descobertos, classificados, gerenciados e protegidos com precisão. É aí que a BigID entra em ação.

A BigID oferece aos líderes de segurança a visibilidade, o controle e a inteligência necessários para proteger os dados que alimentam a IA. A plataforma descobre e classifica automaticamente todos os dados confidenciais, regulamentados e proprietários em nuvem, infraestruturas locais e pipelines de IA, permitindo que as equipes identifiquem quais dados estão sendo usados, para onde estão fluindo e quem pode acessá-los.

Com os recursos de segurança de dados com IA da BigID, as organizações podem:

- Encontre e proteja dados sensíveis e IA. em conjuntos de treinamento de modelos e interações de agentes — antes que os riscos de exposição surjam.

- Detectar e prevenir vazamento de dados com políticas avançadas de classificação e contexto que se alinham com confiança zero Princípios; proteção imediata; e diretrizes de segurança contra riscos da IA

- Governar o acesso aos dados Com controles refinados para garantir o princípio do menor privilégio para agentes de IA – e impor a minimização de dados aos quais a IA pode ter acesso.

- Monitorar e auditar fluxos de dados de IA Identificar anomalias, configurações incorretas ou dados ocultos que aumentam o risco.

- Operacionalizar a governança da IA alinhando as políticas de segurança, privacidade e conformidade entre equipes e tecnologias.

BigID helps enterprises build the foundation for secure, responsible AI – strengthening trust, minimizing risk, and accelerating innovation with confidence.

Resumindo: antes de proteger a IA, você precisa proteger seus dados. A BigID torna isso possível.

A palestra de Allie Mellen desafiou os líderes de segurança a repensarem sua abordagem à segurança da IA. Ao aproveitar frameworks como o Aegis e implementar soluções de líderes do setor como a BigID, as organizações podem proteger sua inovação habilitada por IA, ao mesmo tempo que lidam com os riscos de sistemas agentes e aplicações de IA de última geração. Em um mundo cada vez mais definido pela tomada de decisões baseada em IA, essas medidas não são apenas opções – são necessidades.

Perdeu a discussão ao vivo? Fique por dentro para mais informações. eventos futuros ou Agende uma demonstração individual. Para preparar seu programa de segurança de IA para o futuro.