O IA A era desbloqueou inovações poderosas e criou novas pontos cegos de privacidadeÀ medida que os modelos absorvem volumes massivos de dados e se tornam parte integrante das interações diárias com os clientes, as organizações enfrentam um desafio urgente: Impedir a exposição de dados pessoaismemorizados ou mal utilizados por sistemas de IA. Espera-se agora que os líderes de privacidade, jurídicos e de dados protejam os dados sensíveis em fluxos de trabalho de IA dinâmicos e complexos, sem bloquear a inovação.

O problema: os riscos à privacidade ultrapassaram os controles tradicionais.

Os programas tradicionais de privacidade foram criados para ambientes estáticos — bancos de dados estruturados, fluxos de dados conhecidos e acesso previsível. Mas os sistemas de IA não seguem essas regras. Eles consomem diversos tipos de dados, muitas vezes carecem de rastreabilidade e podem revelar informações sensíveis involuntariamente por meio de inferência.

As principais áreas de risco incluem:

- Treinamento em conjuntos de dados sem consentimento ou classificação apropriados.

- Modelos generativos com vazamento acidental Informações de identificação pessoal em saídas

- IA Sombra e experimentação descentralizada introduzindo pontos cegos

- Aumento da pressão regulatória global (Lei de IA da UE, CPRA, Diretrizes de IA do GDPR)

O que mudou: Os modelos de IA deixaram de ser apenas software — são sistemas orientados por dados que exigem governança contínua e supervisão da privacidade.

Uma estrutura estratégica para a privacidade de dados em IA

Para construir sistemas de IA confiáveis e em conformidade com as normas, os programas de privacidade precisam evoluir. Aqui está uma estrutura geral para orientar essa mudança:

1. Inteligência Artificial para Inventário em Toda a Empresa

- Identificar onde a IA está sendo desenvolvida, implementada ou experimentada.

- Conjuntos de dados de catálogo usados para treinamento, ajuste fino e inferência.

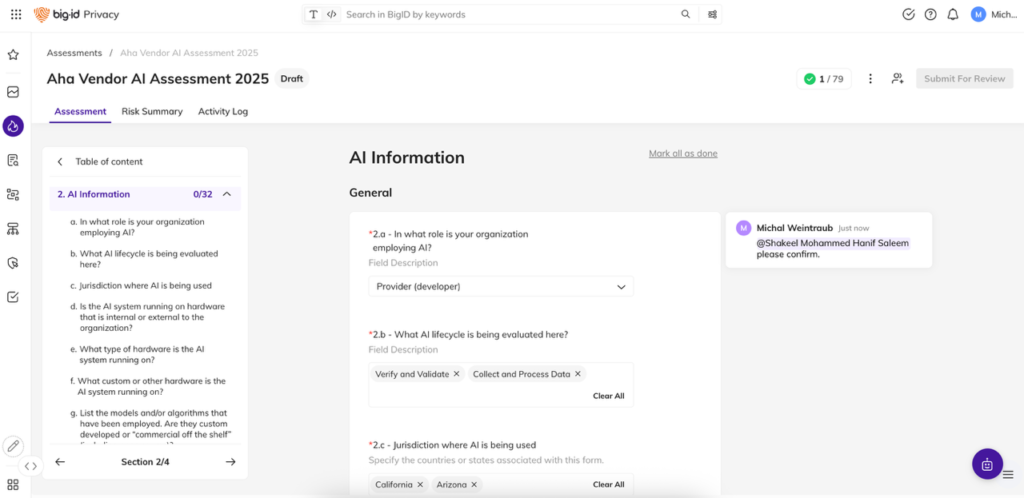

2. Incorporar análises de privacidade no ciclo de vida da IA

- Trate a IA como um fornecedor terceirizado ou uma iniciativa de alto risco.

- Introduza avaliações de risco de privacidade para conjuntos de dados e modelos desde o início.

3. Classificar e monitorar dados relacionados à IA

- Utilize ferramentas automatizadas para etiquetar e sinalizar informações pessoais identificáveis (PII), informações de saúde protegidas (PHI) e outros dados regulamentados.

- Monitore continuamente a ocorrência de desvios de dados, exposição ou violações de políticas.

4. Estabelecer e aplicar controles de dados

- Defina as regras de uso, minimização, retenção e residência.

- Aplicar governança baseada em políticas nas fases de treinamento e inferência.

5. Construir alinhamento interfuncional

- Criar responsabilidade compartilhada entre as áreas de ciência de dados, jurídica, segurança e privacidade.

- Treinar as equipes sobre os riscos de privacidade da IA e os procedimentos operacionais padrão.

A BigID capacita equipes de privacidade, jurídicas e de segurança a operacionalizar a privacidade da IA em grande escala.

Embora a estratégia correta defina a visão, executá-la em escala exige a plataforma certa. A BigID ajuda as organizações a operacionalizar a privacidade em todos os seus fluxos de trabalho de IA, tornando a governança aplicável, transparente e auditável.

A BigID ajuda você a:

- Descubra dados sensíveis em pipelines de IA: Analisa automaticamente dados estruturados e não estruturados usados em treinamento, ajuste e inferência, incluindo arquivos, textos, registros e APIs.

- Classifique dados pessoais e regulamentados com precisão: Identifique informações pessoais identificáveis (PII), informações de saúde protegidas (PHI), informações financeiras e outros atributos sensíveis com modelos de classificação baseados em inteligência artificial, treinados para resultados reais de privacidade.

- Implementar políticas de minimização e retenção de dados: Defina e automatize controles para que apenas os dados corretos sejam usados e retidos apenas pelo tempo necessário.

- Governar IA paralela e modelos não autorizados: Identifique atividades de IA não autorizadas, uso indevido de dados e pontos cegos de risco antes que resultem em violações de conformidade ou danos à marca.

- Habilitar a privacidade desde a concepção em todas as equipes: Capacite as equipes jurídicas e de privacidade com visibilidade contínua sobre onde os dados estão sendo usados, como são governados e quais políticas estão em vigor, sem comprometer a inovação.

O resultado: Ao proteger os dados pessoais desde o início, você reduz a exposição, permite o uso de IA em conformidade com as normas em larga escala e constrói a confiança do consumidor.

A privacidade não pode ser uma reflexão tardia na IA — a BigID a torna uma vantagem intrínseca.

Agende uma demonstração Descubra como a BigID ajuda a proteger dados pessoais em seus sistemas de IA e possibilita inovação confiável e em conformidade com as normas, em grande escala.