Em 2025, as empresas ultrapassaram um limiar crítico. A IA deixou de ser uma assistente passiva e tornou-se um agente ativo nos fluxos de trabalho empresariais: gerando código, emitindo alertas, planejando ações e até mesmo integrando ferramentas por conta própria. Essa nova classe de sistemas de IA — chamada de IA — IA agente—cria oportunidades e riscos em uma escala sem precedentes. Quase todos os setores estão lidando com questões como Como podemos confiar em sistemas autônomos? e Como podemos eliminar as vulnerabilidades de segurança que as ferramentas tradicionais não conseguem detectar? A resposta para equipes com visão de futuro é Remediação Agética—uma nova classe de controles que fecha o ciclo entre detecção e ação em programas de postura de segurança de dados. Este guia oferece uma compreensão completa do que é remediação agente, por que ela é importante e como se relaciona com Gestão da Postura de Segurança de Dados (DSPM), E como operacionalizá-lo sem perder de vista os riscos.

O que é remediação agentiva? Uma definição clara.

A remediação ativa refere-se ao aproveitamento da própria IA ativa para identificar, priorizar e executar ações de redução de riscos em todo o seu ambiente de dados com o mínimo de intervenção manual. Ela supera os fluxos de trabalho reativos atuais, nos quais as equipes identificam riscos, mas ainda têm dificuldades para corrigi-los de forma consistente e em grande escala.

Considere a remediação agentiva como:

- Inteligência artificial que não apenas identifica exposições de dados de risco, mas também sugere — e pode executar — ações seguras.

- Um sistema que aprende continuamente com o contexto para priorizar primeiro as correções de maior impacto.

Isso não é simplesmente automação programada. É adaptativo, contextual, e guiados por inteligência de dados profunda.

Por que a remediação agentiva é crucial em 2026

A IA ativa está agora em toda parte — desde geradores de código até fluxos de trabalho de segurança na nuvem. Mas essa mesma autonomia introduz novos riscos que as ferramentas de detecção tradicionais não conseguem abordar:

1. Superfície de ataque crescente devido a agentes autônomos

Sistemas de IA com agentes executam planos de múltiplas etapas, utilizam ferramentas e tomam decisões sem intervenção humana. Essa capacidade aumenta o número de potenciais pontos de falha e vetores de exploração. Pesquisadores demonstram que a tomada de decisão independente, a memória persistente e a integração de ferramentas em sistemas com agentes criam riscos de segurança que vão muito além das vulnerabilidades clássicas da IA.

2. As ameaças autônomas estão aumentando.

Os cibercriminosos já estão usando IA ativa para automatizar ataques em larga escala — desde phishing até exploração contínua — como visto em recentes alertas do setor sobre “crime de vibração”"e operações adversárias automatizadas de IA.".

3. As ferramentas tradicionais falham diante dos pontos cegos dos agentes

As ferramentas de segurança legadas, como DLP clássico e automação baseada em regras, carecem da consciência contextual necessária para entender por que uma ação é importante ou como responder de forma inteligente quando agentes de IA interagem com dados sensíveis. O DSPM ofereceu a primeira camada de visibilidade e classificação; a remediação por agentes a fornece. Resposta prática aliada ao raciocínio da IA.

DSPM e Remediação Agética: Uma Relação Estratégica

Para entender a remediação de agentes, primeiro é preciso compreender o Gerenciamento da Postura de Segurança de Dados (DSPM).

O que faz o DSPM

O DSPM descobre, inventaria e classifica dados sensíveis em ambientes multicloud, SaaS e híbridos, permitindo que as equipes vejam onde o risco reside e quem tem acesso a ele.

DSPM responde a perguntas cruciais:

- Que dados sensíveis existem?

- Onde está armazenado?

- Quem pode acessar?

- Que impacto isso acarreta em termos de conformidade?

No entanto, o DSPM sozinho ainda deixa uma lacuna de execução. É aí que... remediação de agentes entra.

Como a remediação agética completa o ciclo de vida

A remediação agentiva baseia-se no DSPM adicionando:

- priorização de riscos orientada por IA baseado no contexto real.

- Sugestões de remediação guiada Adaptado ao seu ambiente.

- Execução semiautônoma ou totalmente automatizada de correções.

O BigID combina de forma única DSPM e remediação agentiva. Assim, você não apenas enxerga o risco, mas o reduz com resultados mensuráveis.

Casos de uso reais: da teoria ao impacto

Eis situações práticas em que a remediação agentiva se destaca:

1. Resposta automática à exposição de dados sensíveis

Sua equipe descobre que dados comerciais confidenciais estão sendo amplamente compartilhados em aplicativos SaaS. Em vez de abrir chamados manualmente e passar por ciclos de revisão, a remediação automatizada sugere configurações seguras e pode aplicá-las automaticamente, reduzindo o tempo de correção de dias para horas.

2. Correções de erros de configuração na nuvem

Uma política de IAM de alto risco aplica direitos excessivamente permissivos. A remediação agenciada analisa o contexto, prioriza o risco e sugere ações corretivas exatas que estejam em conformidade com suas políticas de governança.

3. Governança de IA e Prevenção de Perda de Dados para Copilotos

DSPM para IA Identifica solicitações de dados de risco enviadas a ferramentas generativas externas. A remediação automatizada correlaciona tendências de uso e corrige riscos de compartilhamento excessivo antes que se tornem violações de conformidade.

Riscos na operacionalização da IA agente — e como evitar pontos cegos

A remediação ativa introduz poder — e com poder vem a responsabilidade. Aqui estão os principais riscos e como gerenciá-los:

1. Ações desonestas ou equivocadas

Agentes autônomos podem tomar ações que conflitem com as políticas. Sempre aplique diretrizes de governança e fluxos de trabalho de escalonamento para que ações de alto impacto exijam aprovação humana.

2. Sugestões de remediação incorretas

A IA pode ter alucinações ou interpretar o contexto de forma errada. Certifique-se de que seu sistema combine sugestões de IA com inteligência de dados reais e contexto de classificação profundo.

3. Cadeias de dados invisíveis

A remediação por agentes não consegue corrigir o que não consegue ver. Invista na descoberta contínua do DSPM em todos os ambientes e tipos de dados.

4. Requisitos de Governança e Auditoria

Documente cada ação do agente com registros e trilhas de auditoria. Esse nível de visibilidade permite a preparação para auditorias e a validação contínua da conformidade.

Apoio da pesquisa e sinais da indústria

Os modelos da indústria e as pesquisas de segurança validam essas tendências:

- OWASP lançado As 10 principais ameaças e guias de mitigação específicos para segurança de IA agente., destacando as ameaças únicas que os sistemas autônomos representam.

- McKinsey e outros líderes de pensamento em gestão de riscos descrevem as estruturas de segurança em camadas como essenciais para Implantação segura de IA com agentes.

- As empresas de análise estão acompanhando a convergência de DSPM, DLP, e Segurança de IA em plataformas unificadas e orientadas por inteligência.

Roteiro Operacional para 2026 e além

Para ampliar com sucesso a remediação por agentes:

Etapa 1: Visibilidade DSPM de linha de base

Garanta que você tenha um inventário completo dos dados, sua classificação e contexto de acesso em toda a sua infraestrutura.

Etapa 2: Incorporar a priorização guiada por IA

Ative a priorização baseada em agentes para saber quais riscos são mais importantes.

Etapa 3: Definir caminhos de execução seguros

Criar políticas que definam quando a IA pode intervir de forma autônoma e quando a aprovação humana é necessária.

Etapa 4: Feedback e Validação Contínuos

Analise regularmente as ações e os resultados da remediação para refinar a lógica de decisão do agente.

Etapa 5: Alinhar com as necessidades de auditoria e conformidade

Manter comprovação do controle e do histórico de remediação para atender às exigências regulatórias.

Plano de Ação BigID: Operacionalizar a Remediação Agencial com Confiança

1. Estabelecer visibilidade profunda dos dados

Implantar BigID DSPM em ambientes híbridos, multicloud e SaaS para descobrir e classificar Dados sensíveis, regulamentados e proprietários.

Inventarie continuamente os ativos de dados relevantes para IA, como conjuntos de dados de treinamento, entradas de comando, saídas e dados secundários usados por agentes de IA.

2. Mapeie o risco da IA em seus dados

- Use a IA da BigID mapeamento de dados capacidades de detecção:

- Artefatos de dados gerados por IA

- Uso de LLM por terceiros

- Fluxos de dados para ferramentas de IA generativa

3. Priorize os riscos com inteligência contextual.

- Aproveitar Pontuação de risco contextual da BigID Classificar as ameaças por:

- Impacto nos negócios

- Exposição regulatória

- envolvimento do sistema de IA

4. Ativar fluxos de trabalho de remediação de agentes

- Configurar automatizado ou políticas de remediação guiadas para:

- Dados superexpostos em ferramentas de colaboração

- Direitos tóxicos em ambientes de nuvem e SaaS

- Acesso inadequado a conjuntos de treinamento de IA

5. Estabelecer diretrizes de governança

- Utilize o mecanismo de políticas do BigID para aplicar as seguintes medidas:

- Limitações de remediação baseadas em funções

- Fluxos de trabalho de remediação alinhados à conformidade (por exemplo, para RGPD, HIPAA, CPRA)

- Protocolos de remediação específicos para IA (por exemplo, remoção de dados não consentidos de conjuntos de treinamento)

6. Auditar, validar e relatar

Mantenha um registro completo de todas as ações do agente e das intervenções humanas.

Integre os relatórios do BigID com plataformas SIEM/SOAR para dar suporte à geração de relatórios de segurança e conformidade.

Gere painéis de controle em tempo real para monitorar eficácia da remediação e Tendências na postura de risco em IA.

7. Otimize com feedback contínuo

Utilize as análises aprimoradas por aprendizado de máquina do BigID para aprender com os resultados de remediação anteriores.

Aprimorar a detecção de riscos por IA e a resposta automatizada ao longo do tempo.

Alinhar-se com os padrões regulatórios em evolução para IA (por exemplo, Lei de IA da UE, Declaração de Direitos da IA dos EUA, NIST RMF).

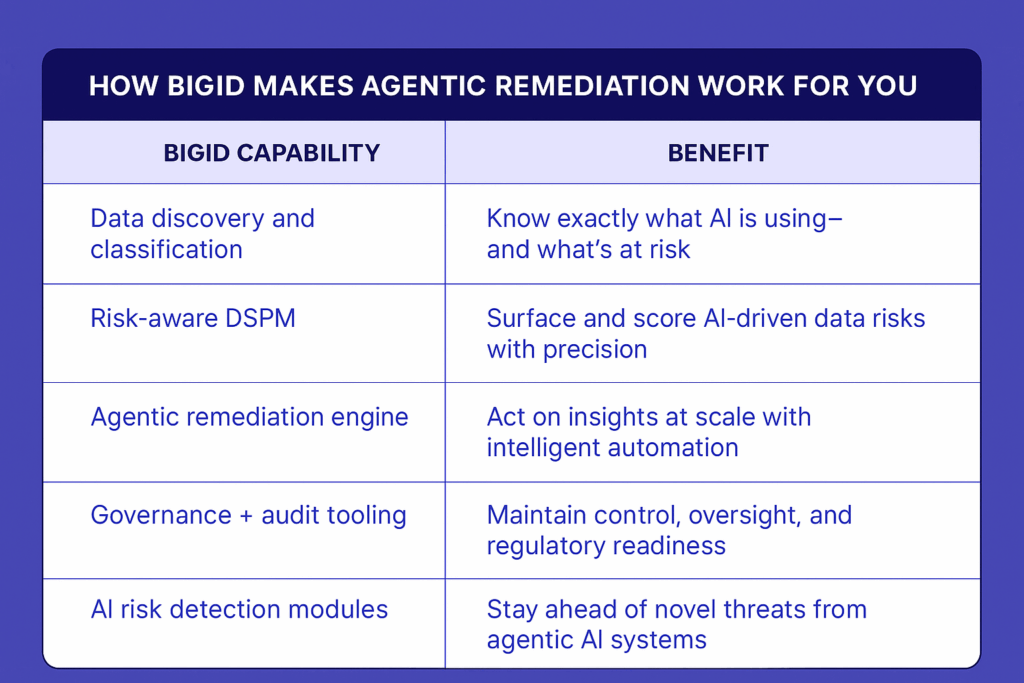

Como o BigID faz a remediação de agentes funcionar para você

Resumindo: O BigID oferece a visibilidade, a inteligência e o controle necessários não apenas para acompanhar os riscos impulsionados por IA, mas também para antecipá-los. A remediação automatizada não é opcional em 2026. Com o BigID, ela já vem integrada.

Veja a remediação agentiva em ação—Agende uma demonstração individual com nossos especialistas em segurança. Para explorar como a BigID pode reduzir o risco impulsionado por IA em seus dados.