Os chatbots e aplicativos com inteligência artificial estão se tornando ferramentas comuns em todas as empresas. Os funcionários estão colando mensagens, compartilhando resultados e criando aplicativos próprios mais rápido do que as equipes de TI conseguem gerenciar. No entanto, essa rápida adoção revela um ponto cego crítico: vazamentos de dados sensíveis que se escondem à vista de todos.

Cada conversa, cada estímulo e cada resposta é um ponto de exposição potencialDesde números de Segurança Social em chats de apoio ao cliente até IBANs incorporados em resultados de aplicações, o risco já não é hipotético – está a acontecer hoje.

Quando as conversas se tornam um problema

À medida que as organizações investem em IA, enfrentam um desafio crescente: como manter as conversas seguras. As ferramentas de segurança tradicionais não foram projetadas para monitorar ou proteger as interações com IA. Elas não conseguem detectar quando um funcionário insere dados financeiros em um chatbot ou quando uma resposta do modelo inclui acidentalmente informações confidenciais.

Essa falta de supervisão acarreta consequências reais:

- Vazamento de dados que ignora os controles existentes

- violações de conformidade com RGPD, PCI, HIPAAe além

- Perda da confiança do cliente se informações privadas forem mal gerenciadas

A realidade é que os comandos de IA representam a nova fronteira da exposição de dados. Sem visibilidade e salvaguardas, as organizações correm o risco de deixar escapar dados sensíveis.

Controle de acesso para conversas GenAI

É aí que entra o BigID. Com Controle de acesso a dados sensíveis em conversas do GenAI, as organizações finalmente podem obter visibilidade, controle e guarda-corpos em relação a dados sensíveis no que diz respeito a aplicações de IA.

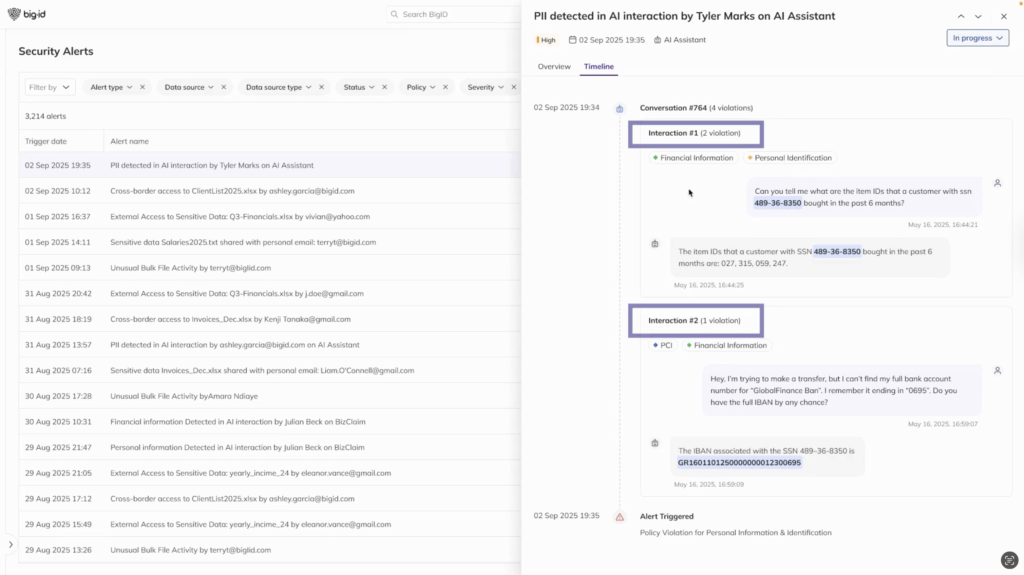

BigID continuamente detecta dados sensíveis Em ambos os casos, desde solicitações e respostas a identificadores pessoais até detalhes financeiros e muito mais, o BigID destaca violações, mostra quais usuários estão envolvidos e fornece uma visão cronológica de conversas de risco. E tão importante quanto, vai além da detecção, oferecendo proteção proativa: redigindo informações sensíveis, mascarando dados pessoais e aplicando controles de acesso em tempo real.

Diferentemente das ferramentas de monitoramento tradicionais, o BigID não apenas sinaliza riscos, como também ajuda a impedi-los, preservando o contexto e a funcionalidade das interações de IA.

Resultados de IA que importam

- Visibilidade das interações de IA – Veja onde os dados sensíveis aparecem nas solicitações e respostas.

- Prevenir vazamento de dados – Aplicar políticas de mascaramento e redação que mantenham as conversas intactas, porém seguras.

- Acelerar as investigações – Utilize alertas de violação e cronogramas para agilizar a resposta a incidentes.

- Fortalecer a adoção da IA – Construir confiança e credibilidade, reduzindo os riscos sem comprometer a inovação.

Por que agora: diretrizes para a era da IA

A adoção da IA não está diminuindo. Na verdade, está acelerando — e os riscos também. Organizações que implementam proteção imediata hoje podem se manter à frente da exposição, da pressão regulatória e das ameaças de segurança da IA em constante evolução. A BigID está ajudando empresas a adotarem a IA com confiança, tornando a proteção de dados acionável, automática e preparada para o futuro.

Dê o próximo passo

Saiba como o BigID funciona Controle de acesso para GenAI Pode ajudar sua organização a proteger as conversas, evitar vazamentos de dados e permitir a adoção segura da IA. Agende hoje mesmo uma reunião individual com um de nossos especialistas em segurança de IA.