Agentes de IA Ya no son herramientas experimentales confinadas a los laboratorios de innovación. Ya están integradas en entornos empresariales: leen archivos, responden a tickets, aprovisionamiento de acceso, generando informes e iniciando remediación acciones en sistemas críticos. Su adopción se está acelerando porque reducen la fricción y automatizan la toma de decisiones a gran escala.

Sin embargo, muchas organizaciones implementan estos agentes bajo una suposición arriesgada: que los controles de IAM, la seguridad de los modelos o los marcos de gobernanza de IA de alto nivel existentes son suficientes. Si bien estos controles siguen siendo necesarios, son fundamentalmente incompletos para los sistemas autónomos que pueden razonar, actuar, acceder y transferir continuamente datos confidenciales sin intervención humana.

Los agentes de IA no son solo modelos. Son actores operativos. Y los actores que operan a la velocidad de una máquina, con acceso persistente a datos empresariales, requieren una nueva disciplina de seguridad: una basada en datos, no solo en la identidad o la infraestructura. Esta es la base de... Gestión de la postura del agente de IA.

Agentes autónomos como infiltrados invisibles

Los equipos de seguridad son expertos en la gestión del riesgo humano. Realizan un seguimiento de usuarios, roles, permisos y actividad para comprender quién tiene acceso a qué y por qué. Este modelo se desmorona al aplicarse a agentes de IA.

Los agentes no inician sesión de forma interactiva, solicitan acceso repetidamente ni experimentan fricción al actuar. Una vez implementados, muchos operan continuamente mediante cuentas de servicio, aplicaciones OAuth o claves API, a menudo al margen de las revisiones de identidad tradicionales. Con el tiempo, funcionan como agentes internos con privilegios permanentes.

Este desafío a menudo se enmarca como un Gobernanza de la IA problema, pero en esencia, es un problema de seguridad de datos. El riesgo principal no es el agente en sí, sino los datos confidenciales, regulados y críticos para el negocio a los que puede acceder y sobre los que puede actuar.

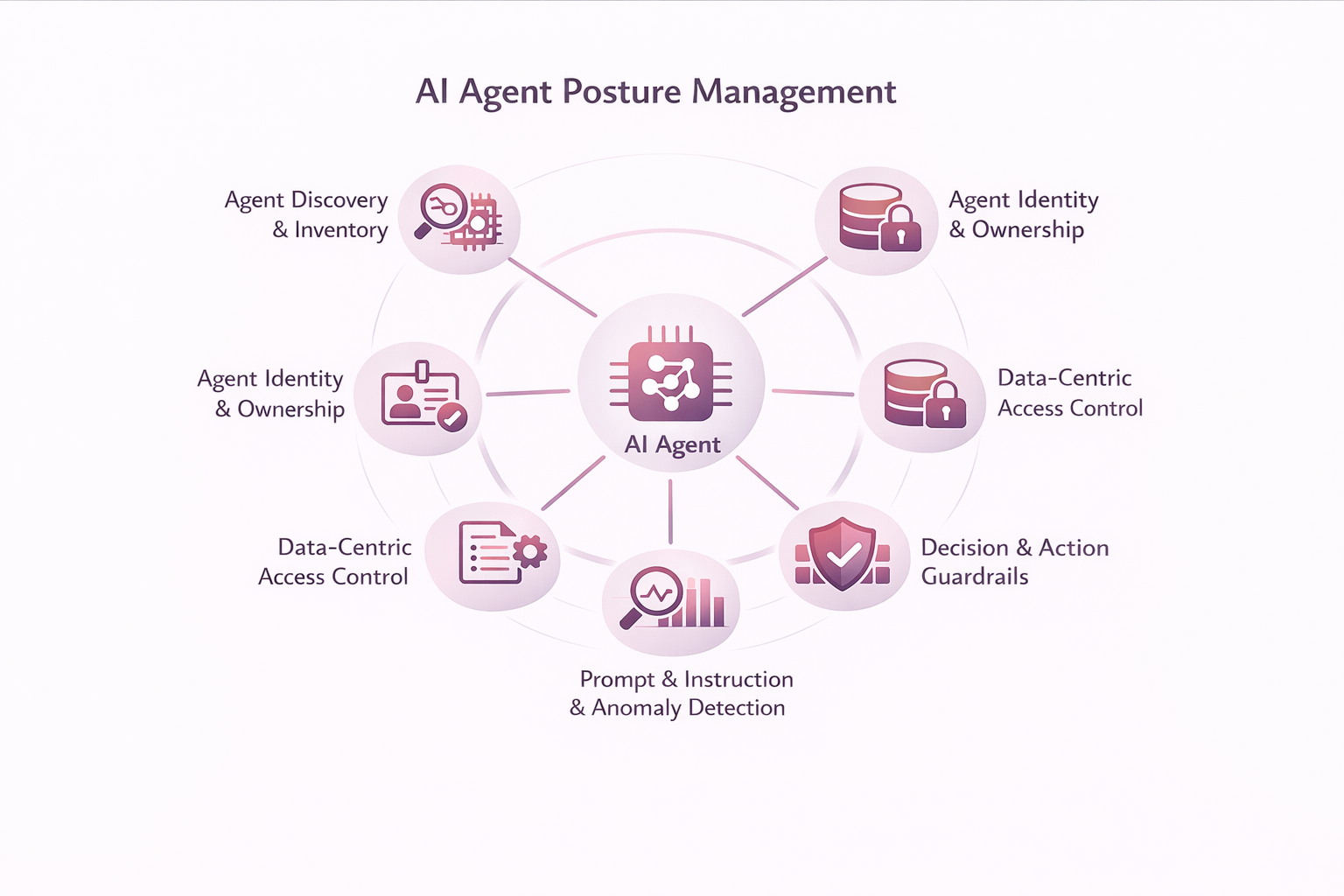

Definición de la gestión de la postura del agente de IA

La gestión de la postura de los agentes de IA ofrece visibilidad, control y gobernanza continuos de lo que los agentes de IA pueden acceder, decidir y hacer en los datos empresariales. Amplía la gestión de la postura de seguridad a los agentes autónomos cuyo comportamiento no se puede prever completamente en el momento de la implementación.

En la práctica, permite a los líderes de seguridad responder preguntas que los enfoques centrados en la identidad o el modelo no pueden abordar de manera confiable:

¿A qué datos puede acceder este agente y qué datos utiliza realmente? ¿Qué acciones puede tomar con esos datos? ¿Su comportamiento sigue alineado con la política y la intención? Y cuando algo sale mal, ¿se pueden explicar, limitar o detener sus acciones?

Sin visibilidad y control a nivel de datos, estas preguntas quedan sin respuesta, independientemente de lo bien que se gestionen las identidades o se gobiernen los modelos.

Capacidades principales de la gestión de la postura del agente de IA

Descubrimiento e inventario de agentes

La gestión de la postura de los agentes de IA comienza con la visibilidad. Las organizaciones no pueden controlar lo que no ven, y la mayoría de las empresas carecen de un inventario completo de los agentes de IA que ya operan en sus entornos.

Los agentes son creados por desarrolladores, integrados en plataformas SaaS, implementados mediante herramientas de automatización o habilitados por funciones de IA en aplicaciones existentes. Muchos se autentican de forma no interactiva y operan de forma continua, lo que los sitúa fuera de los inventarios de identidad tradicionales.

Descubrimiento de agentes Establece las bases para la gestión de la postura al identificar e inventariar continuamente agentes en toda la empresa, incluidos:

- Descubrimiento de agentes de IA en todas las aplicaciones, servicios en la nube y marcos de automatización

- Identificación de identidades no humanas, como entidades de servicio, aplicaciones OAuth y acceso basado en API

- Correlación de los agentes con los datos a los que realmente acceden y modifican

- Detección de sistemas no administrados, inactivos o agentes sobreprivilegiados

Sin descubrimiento, los agentes operan como infiltrados invisibles. Con ello, los controles de postura pueden aplicarse de forma intencionada y consistente.

Identidad y propiedad del agente

Una vez descubiertos, los agentes deben ser propiedad de sus dueños y responsables. Cada agente de IA debe ser tratado como un agente de seguridad de primera clase con un propósito y alcance definidos.

La identidad y la propiedad del agente garantizan la responsabilidad mediante:

- Asignar una identidad única y auditable a cada agente

- Definir un propietario claro y un propósito comercial documentado

- Establecer límites de alcance explícitos en todos los sistemas y dominios de datos

Sin embargo, la identidad por sí sola no es suficiente. Saber OMS un agente no explica Qué datos utiliza o cómo se comporta a lo largo del tiempo—es por eso que la identidad debe estar emparejada con el contexto de los datos.

Clasificación de agentes y elaboración de perfiles de riesgo

El descubrimiento y la identidad no establecen la postura por sí solos. No todos los agentes corren el mismo riesgo, y los permisos por sí solos ofrecen una visión incompleta.

Clasificación de agentes y Perfiles de riesgo evalúa a los agentes en función del comportamiento observado, incluyendo:

- La sensibilidad y la naturaleza regulatoria de los datos a los que se accede

- ¿Qué agentes de datos realmente leen, escriben o propagan?

- La amplitud del acceso a través de sistemas y regiones

- El nivel de autonomía y autoridad de acción del agente

Los perfiles de riesgo deben actualizarse continuamente a medida que los agentes evolucionan. Al basar la clasificación en la interacción de datos reales, las organizaciones pueden enfocar los controles donde más importan.

Control de acceso centrado en datos

Los permisos a nivel de sistema son demasiado generales para los agentes autónomos que interactúan directamente con información confidencial.

El control de acceso centrado en datos aplica el mínimo privilegio en la capa de datos al permitir:

- Visibilidad del acceso de los agentes a datos específicos

- Decisiones de acceso conscientes de la sensibilidad basadas en la clasificación y el riesgo

- Acceso limitado por tareas y tiempo en lugar de privilegios permanentes

Sin controles a nivel de datos, las organizaciones no pueden evitar la sobreexposición, incluso si las identidades y los permisos parecen correctos en el papel.

Barandillas de decisión y acción

Los agentes de IA no se limitan al análisis: actúan. A medida que aumenta la autonomía, también aumenta el impacto potencial.

Los límites de decisión y acción definen límites operativos, entre ellos:

- Límites explícitos a las acciones permitidas

- Aprobación humana en el circuito para decisiones de alto riesgo

- Salvaguardias para acciones irreversibles, como la eliminación o el uso compartido

- Interruptores de seguridad y rutas de reversión

La automatización sin barreras amplifica el riesgo en lugar de la eficiencia.

Gobernanza de la instrucción y la prontitud

Las indicaciones e instrucciones del agente son una superficie política fundamental que influye directamente en el comportamiento.

La gobernanza de instrucciones y avisos permite a las organizaciones:

- Instrucciones del agente de versión y auditoría

- Detectar desviación o manipulación rápida

- Separar la intención del sistema del contexto proporcionado por el usuario

- Aplicar políticas de datos y cumplimiento dentro del razonamiento del agente

Sin visibilidad de las instrucciones, el comportamiento del agente se vuelve impredecible e ingobernable.

Monitoreo continuo y detección de anomalías

Los controles estáticos fallan en entornos dinámicos. La gestión de la postura del agente con IA requiere visibilidad continua del comportamiento del agente.

La monitorización continua y la detección de anomalías proporcionan:

- Monitoreo continuo del acceso a los datos y acciones

- Línea base del comportamiento por agente

- Detección de comportamientos anómalos o que infringen las políticas

- Correlación con identidad, riesgo de datos y señales de amenaza

Esto permite una intervención temprana, antes de que desviaciones menores se conviertan en incidentes.

Los riesgos que esta disciplina está diseñada para prevenir

Sin estas capacidades, las organizaciones se enfrentan a riesgos crecientes: infiltración de privilegios, exfiltración silenciosa de datos a través de flujos de trabajo legítimos, inyección inmediata de datos y pérdida de responsabilidad durante las investigaciones. Cuando ocurren incidentes, atribuir los resultados a la IA no es suficiente ni justificable.

Por qué la gestión de la postura del agente de IA se basa fundamentalmente en los datos

Gran parte del mercado se centra en proteger modelos o gestionar identidades. Estos enfoques son necesarios, pero no abordan el riesgo más importante: cómo interactúan los agentes autónomos con los datos empresariales a lo largo del tiempo.

- Los controles de solo identidad no pueden ver la sensibilidad de los datos ni el uso real.

- Los controles basados únicamente en el modelo no pueden gobernar acciones posteriores.

Sin contexto de datos, la postura se infiere, no se impone. La gestión de la postura del agente de IA debe basarse en un plataforma de seguridad centrada en los datos que comprende la sensibilidad, la exposición y la actividad de los datos en tiempo real.

Cómo BigID facilita la gobernanza centrada en los datos para los agentes de IA

BigID Ayuda a las organizaciones a descubrir y clasificar datos confidenciales, comprender el acceso y la exposición, supervisar la actividad de los datos e implementar medidas correctivas basadas en políticas a escala. La Gestión de la Postura del Agente de IA extiende estas capacidades a los agentes autónomos que operan en todo el conjunto de datos.

En lugar de preguntarse si un modelo de IA es "seguro", las organizaciones deberían plantearse una pregunta más práctica: ¿Se mantienen nuestros datos bajo control cuando se permite que la IA actúe? Este cambio es lo que permite la adopción de la IA sin sacrificar el control.

De la gobernanza de la IA a la postura del agente

Los agentes de IA ya operan a gran escala en entornos empresariales. Las organizaciones que los tratan como simples herramientas tendrán dificultades para mantener el control. Aquellas que los tratan como identidades, gobernadas mediante controles centrados en datos, escalarán la IA de forma segura y responsable.

La gestión de la postura de los agentes de IA no es una consideración futura. Es la próxima evolución de la seguridad de datos, y definirla con antelación garantiza que evolucione según sus términos, no en respuesta a un incidente.

¿Quieres saber más? Programar una reunión 1:1 con uno de nuestros expertos en inteligencia artificial y seguridad de datos.