Inventário de ativos de IA

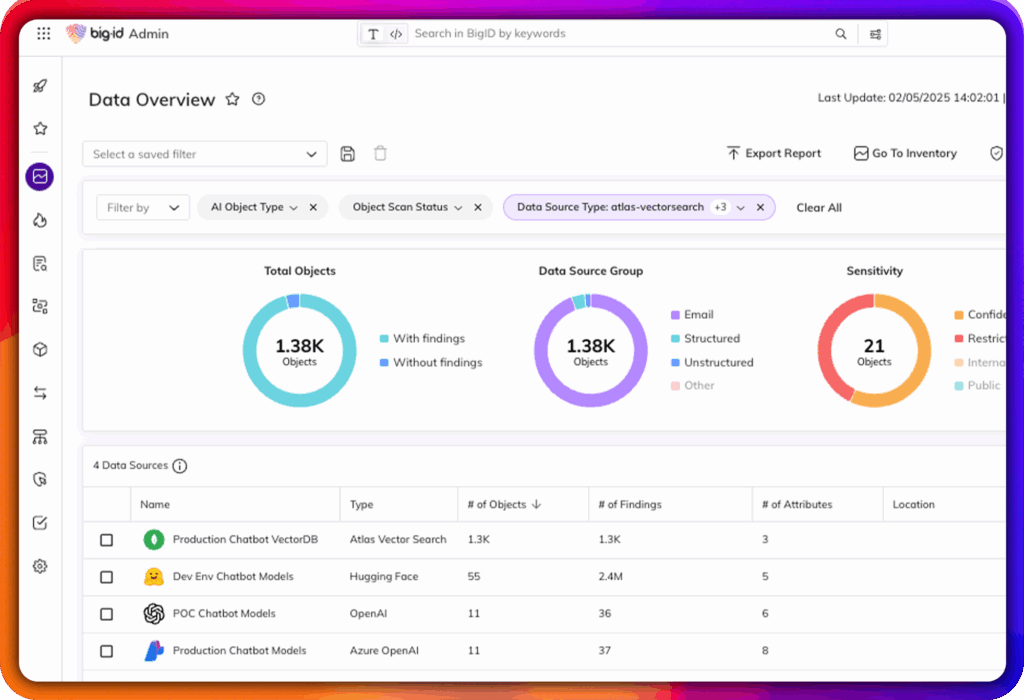

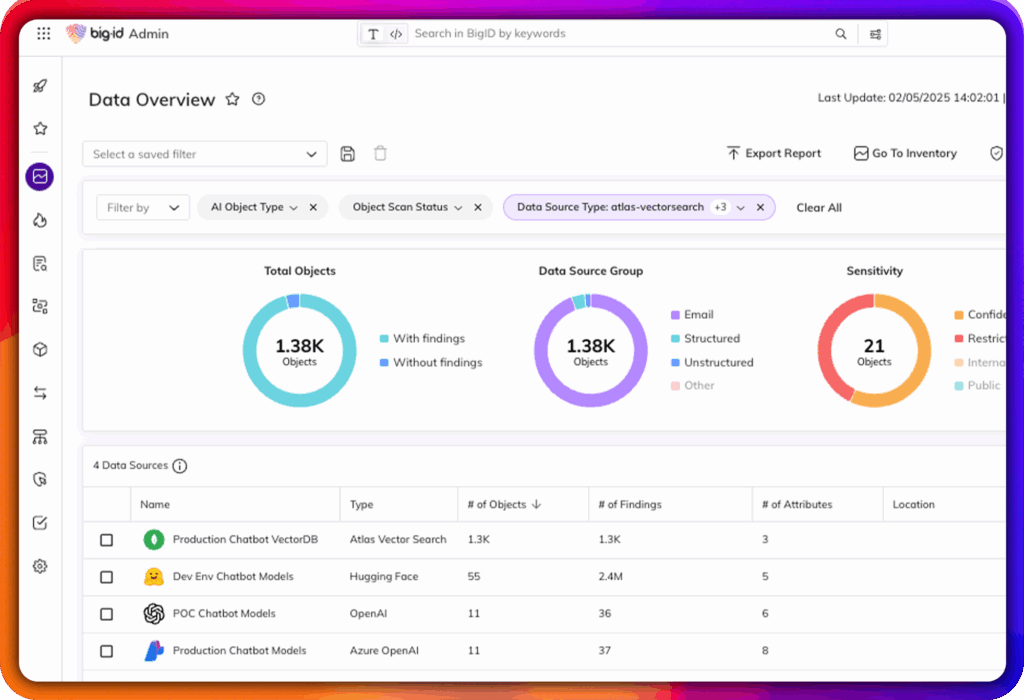

Descubra e catalogue automaticamente seus modelos de IA, conjuntos de treinamento, conjuntos de dados, copilotos e aplicativos orientados por IA em ambientes de nuvem, SaaS e locais.

Detectar automaticamente modelos de IA, copilotos e ferramentas de terceiros em uso — autorizadas ou não.

Manter um inventário centralizado e continuamente atualizado de sistemas de IA e dados associados.

Acompanhe onde os modelos são implantados, quais dados eles usam e como estão sendo aplicados.

Defina e aplique o acesso baseado em funções aos dados de treinamento, instruções, resultados e modelos.

Identificar e mitigar usuários com permissões excessivas e o uso oculto de IA.

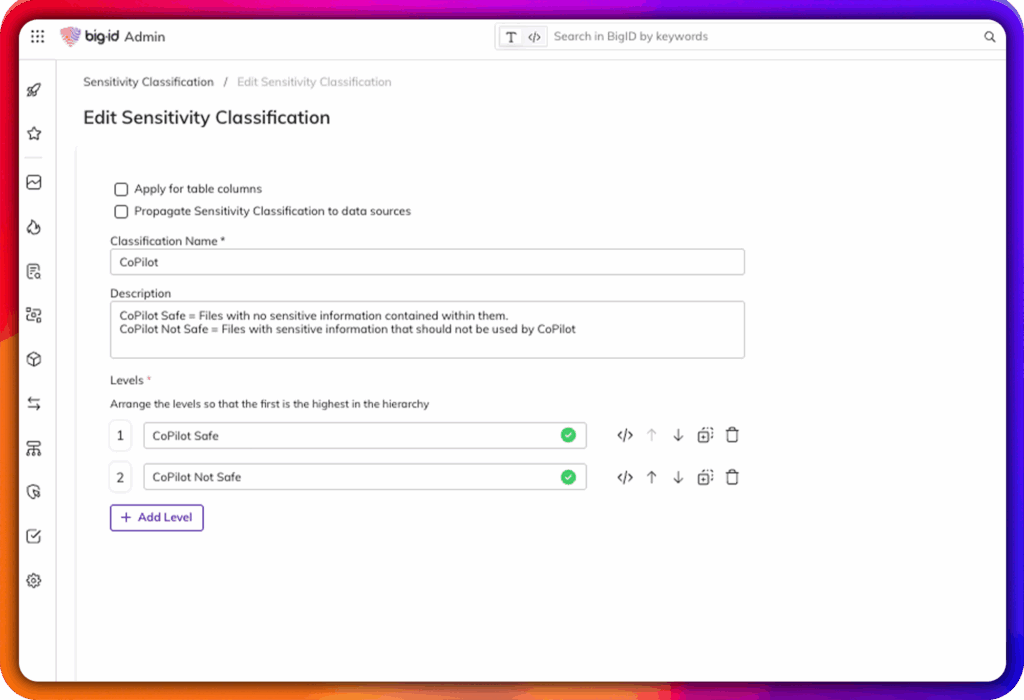

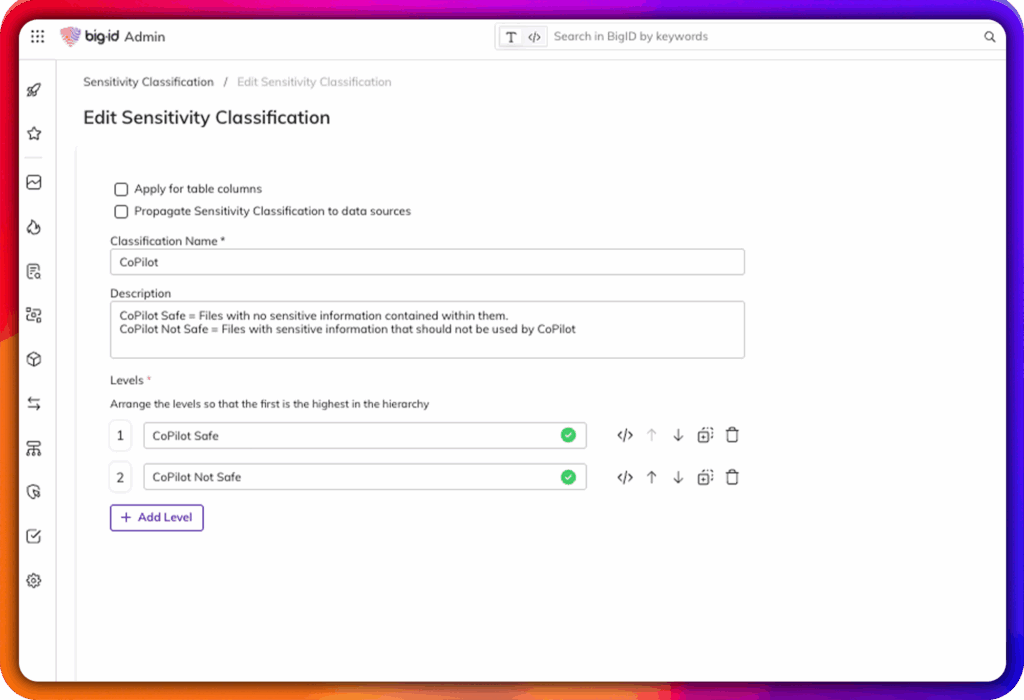

Limitar o acesso da IA apenas a conjuntos de dados aprovados, em conformidade com as normas e alinhados à finalidade.

Aplique controles de governança desde a ingestão de dados até a implantação e utilização do modelo.

Monitore os riscos específicos da IA: viés, vazamento de dados, violações de políticas e uso não autorizado.

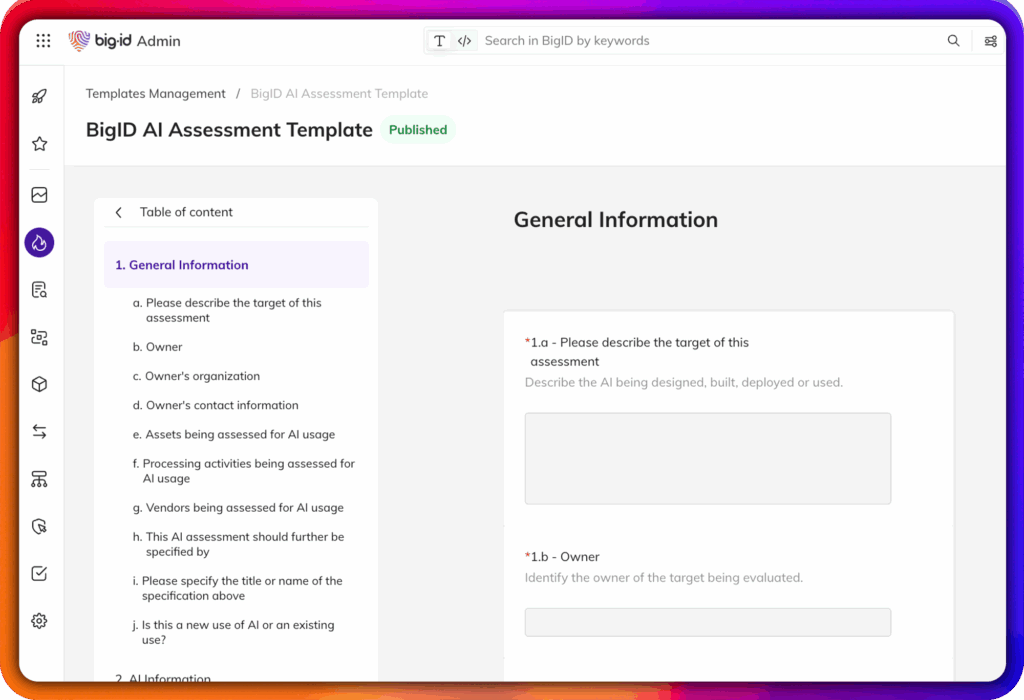

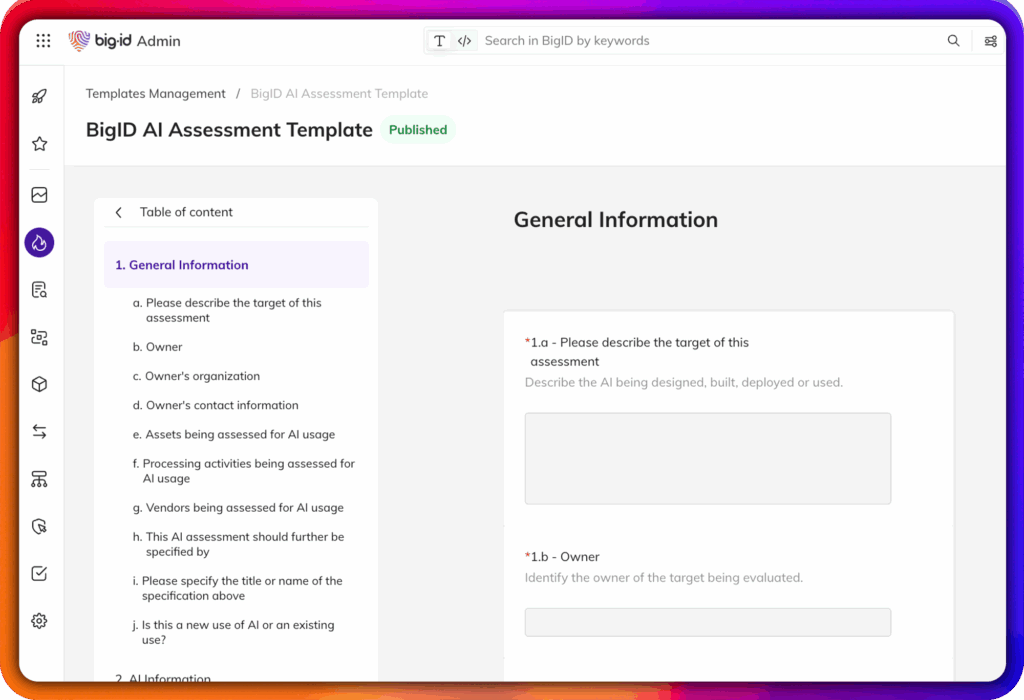

Automatize a conformidade com estruturas globais como NIST AI RMF, Lei de IA da UE e ISO 42001.

A BigID operacionaliza a Gestão de Confiança, Risco e Segurança com IA, oferecendo funcionalidades reais – e não apenas promessas vazias:

Descubra e catalogue automaticamente seus modelos de IA, conjuntos de treinamento, conjuntos de dados, copilotos e aplicativos orientados por IA em ambientes de nuvem, SaaS e locais.

Identificar e classificar os dados sensíveis, regulamentados ou críticos que alimentam os modelos de IA – garantindo uma IA responsável desde a sua concepção.

Controle e monitore quem pode acessar modelos, conjuntos de dados de treinamento e pipelines de IA. Garanta o princípio do menor privilégio e a confiança zero em todos os ambientes de IA.

Descubra atividades de IA não autorizadas, copilotos desonestos e implantações de modelos ocultos que possam representar riscos ou violar políticas.

Governar políticas específicas de IA para privacidade, residência de dados, segurança e conformidade regulatória — incluindo estruturas emergentes como a Lei de IA da UE, o NIST AI RMF e a ISO/IEC 42001.

Identificar problemas como dados de treinamento superexpostos, acesso inseguro ou conjuntos de dados propensos a vieses e tomar medidas para corrigi-los antes que se agravem.

Rastrear a origem, a evolução e a utilização de dados e modelos de treinamento, apoiando práticas de IA transparentes e explicáveis para auditorias, conformidade e governança.

Alerta e toma medidas em relação a violações de acesso, riscos de IA não autorizada, descumprimento de políticas e ameaças emergentes aos seus ambientes de IA.

Viabilize a inovação em IA confiável, responsável e resiliente com o AI TRiSM da BigID.